Blackwell Ultra : Nvidia GB300 dispose de 288 Go HBM3e et 1,4 kW par GPU 46 commentaires

Image : Nvidia

Les données techniques pour la mise à niveau vers Blackwell Ultra proviennent de la chaîne d’approvisionnement taïwanaise. Nvidia avait déjà annoncé le rafraîchissement à mi-cycle de l’architecture Blackwell au Computex en juin, et maintenant des détails pour le GB300 tels que la quantité de HBM3e installée (288 Go) ou la consommation par GPU (1 400 watts) sont révélés.

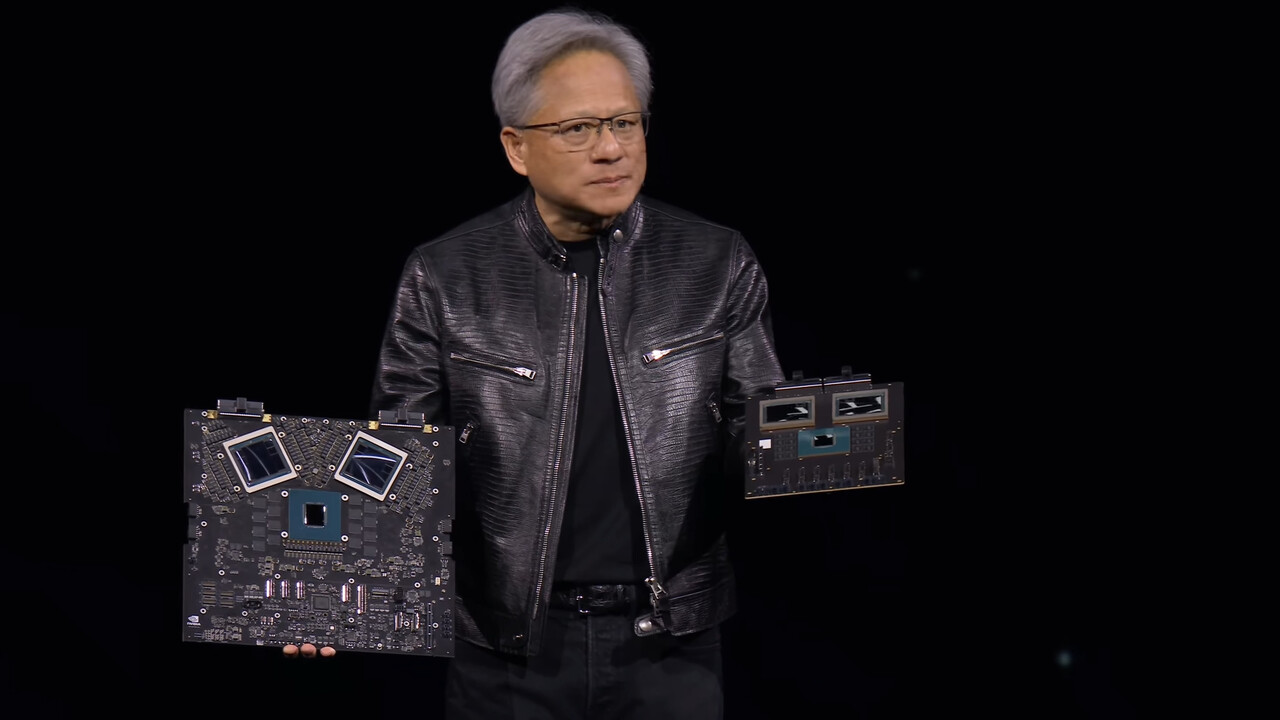

Le fabricant a annoncé aux investisseurs il y a environ un an que Nvidia accélérerait le rythme de l’introduction de nouvelles solutions pour le supercalcul IA. Lors du discours d’ouverture du Computex en juin de cette année, le PDG Jensen Huang s’est montré étonnamment ouvert et a donné au public un aperçu des successeurs de Blackwell, Blackwell Ultra, Rubin et Rubin Ultra pour les prochaines années.

Blackwell Ultra avec 288 Go HBM3e

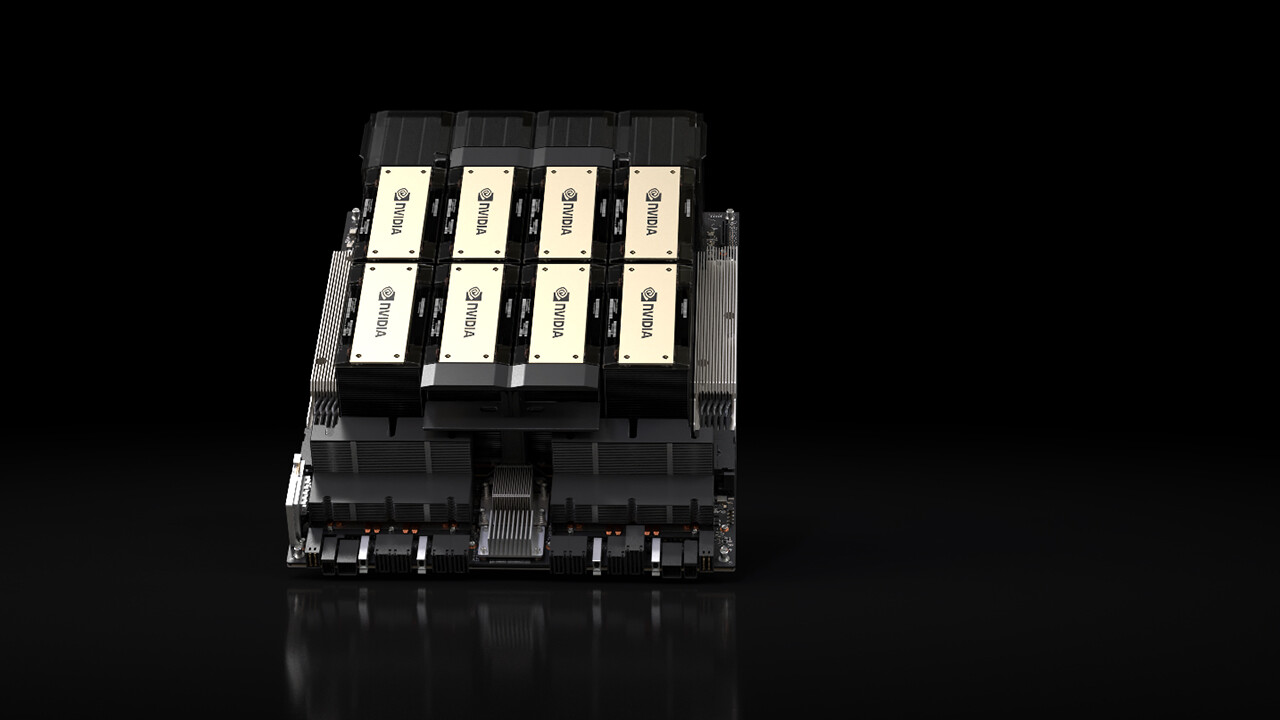

En conséquence, la mise à jour de mi-cycle du Blackwell Ultra est prévue pour l’année prochaine. Nvidia avait déjà officiellement annoncé la fonctionnalité « 8S HBM3e 12H » à cet effet. Cela signifie : 8 piles HBM3e, chacune comportant 12 couches, sont utilisées. L’extension de mémoire par GPU devrait passer des 192 Go actuels à 288 Go, rapporte le Economic Daily de Taiwan en référence à la chaîne d’approvisionnement.

Cependant, le chiffre de 288 Go n’est pas surprenant, puisque Blackwell (sans Ultra) utilise actuellement 8 piles de HBM3e, chacune comportant 8 couches, ce qui le porte à 192 Go. 50 % de couches en plus avec Blackwell Ultra signifie 50 % de mémoire en plus et donc 288 Go.

Le TDP augmente modérément

Le rapport de l’Economic Daily porte principalement sur le GB300, le successeur de la superpuce GB200. C’est ainsi que Nvidia appelle la carte avec deux GPU B200 et un CPU Grace. 36 de ces cartes composent le GB200 NVL72, un rack dense et refroidi par eau avec 72 GPU Blackwell, 36 processeurs Grace, 13,5 To HBM3e et jusqu’à 1 440 PetaFLOPS de performances (FP4 Tensor Core Sparse). Chaque carte Superchip dispose d’un TDP configurable de 2 700 watts. Ceci est important en ce qui concerne Blackwell Ultra.

L’article indique un TDP de 1 400 watts pour le GPU B300. Cela semble beaucoup, mais ce n’est pas beaucoup plus que B200. Deux GPU Blackwell Ultra atteindraient un maximum de 2 800 watts, et il faudrait alors ajouter le CPU Grace et d’autres composants de la carte afin de pouvoir comparer la consommation avec le précédent Superchip GB200. Il est prévisible que la consommation par carte sera plus élevée, mais la différence ne sera pas dramatique si on la compare à l’augmentation des performances. Les performances du FP4 augmenteraient de 50 % pour atteindre 2 160 PetaFLOPS avec Blackwell Ultra lors de l’utilisation de l’accélération par parcimonie.

LPCAMM pour le processeur Grace

Outre le HBM3e des GPU, 480 Go de LPDDR5X pour le processeur Grace sont également soudés sur chaque Superchip GB200. La prochaine génération introduira le LPCAMM modulaire, prévu dès le départ pour les ordinateurs portables, les ordinateurs de bureau et les serveurs.

Modifications du refroidissement et du stockage d’énergie

Pour les nouveaux serveurs AI équipés de Blackwell Ultra, le nombre de déconnexions rapides universelles (UQD) pour le refroidissement par eau devrait être augmenté, ce qui rendrait le système plus modulaire. Dans les nouveaux racks, de l’espace sera également créé pour les unités de batterie de secours (BBU) et les supercondensateurs afin d’utiliser cette énergie pour amortir les pannes.

La mise en réseau devrait doubler pour atteindre 1,6 Tbit/s

De plus, Nvidia prévoit de doubler la prochaine vitesse de réseau pour la porter à 1,6 Tbit/s. L’Economic Daily met en jeu une mise à niveau de l’ancien adaptateur InfiniBand ConnectX-7 vers le ConnectX-8. Selon la feuille de route du Computex de juin, 1,6 Tbit/s n’était prévu que pour la plateforme Rubin et son ConnectX-9, attendu l’année prochaine. Le ConnectX-8 est également déjà utilisé dans les solutions Blackwell actuelles et fournit une bande passante de 800 Gbit/s.

Sujets : Cartes graphiques Intelligence artificielle Nvidia Nvidia Blackwell Source : Economic Daily

Ingénieur de formation, Alexandre partage ses connaissances sur les performances des GPU pour le gaming et la création.