GB300 NVL72: Nvidia Blackwell Ultra opgraderer til 288 GB HBM3E 17 kommentarer

Billede: nvidia

Nvidia præsenterede en videreudvikling af den nuværende Blackwell-arkitektur med Blackwell Ultra til GTC 2025. Dette skulle gøre datacenterløsningen aldersjusteret til AI-implementeringsmodeller med et højere inferenskrav.

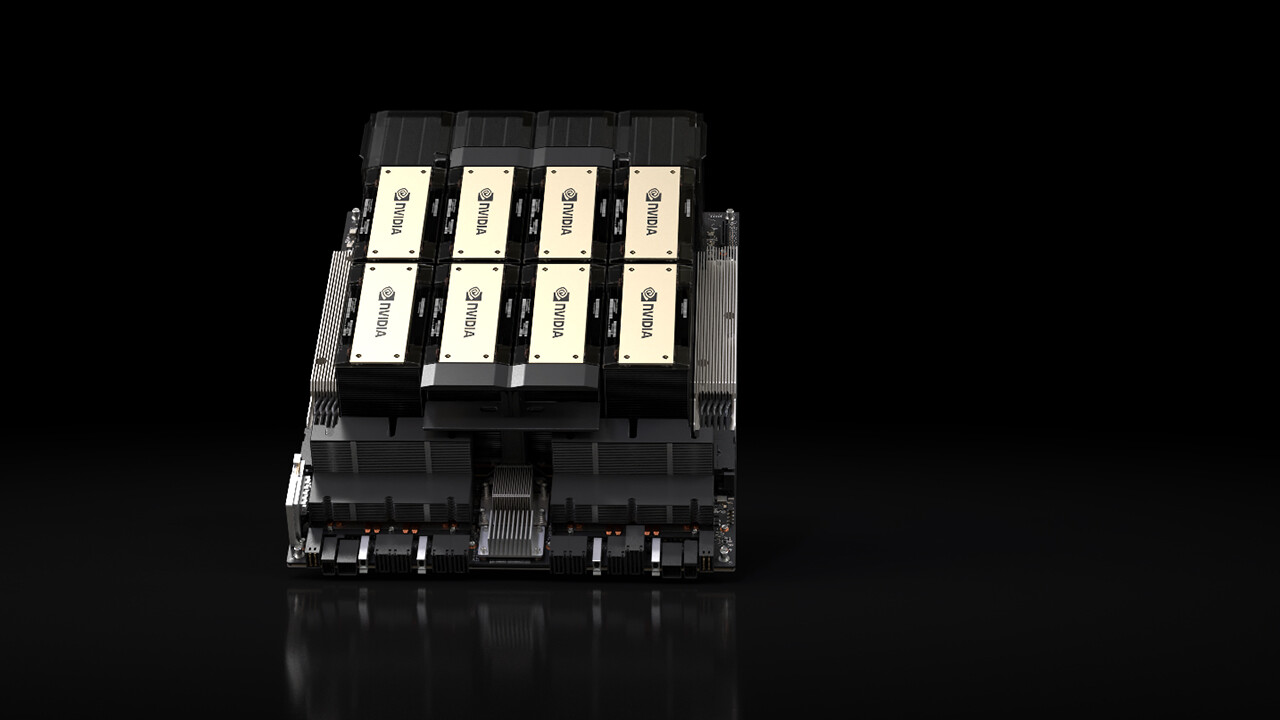

B300 GPU’en er en videreudvikling af B200 GPU’en, der blev præsenteret sidste år, som NVIDIA annoncerede Blackwell-arkitekturen med, og som har været hos flere cloud-tjenesteudbydere (CSP’er) i datacentret siden slutningen af sidste år. Blackwell Ultra bygger på den samme arkitektur og inkluderer derfor også to af disse, som er forbundet med hinanden via en matrix.

Fokuser på at udlede AI-overførselsmodeller

Blackwell Ultra er blandt andet udviklet til de højere krav, når man udleder AI-overførselsmodeller, som hurtigt skal behandle og bruge flere hundrede tusinde tokens pr. anmodning, fordi de også præsenterer anmodningen on demand for brugeren og dermed kræver en højere beregningsindsats.

HBM3E når 288 GB

For at opfylde disse krav udvider Nvidia hovedsageligt hukommelsen i Blackwell Ultra op til 288GB HBM3E, baseret på 192GB HBM3E nær Blackwell med B200 GPU. Den 50 % større båndbreddehukommelse fordeler igen Nvidia på tværs af otte stakke rundt om GPU’en, men de respektive stakke er nu 12 i stedet for 8 DRAM-chips, så der opnås 50 % højere lagertæthed over det samme område.

1,5x FP4 inferens ydeevne

Ifølge NVIDIA ville Blackwell Ultra tilbyde 1,5 gange FP4 inferens ydeevne sammenlignet med Blackwell, virksomheden taler om 15 Petaflops for tætte FP4, det vil sige uden sparsitetsaccelerationen, hvormed 30 PETA flops er mulige. For den originale Blackwell GPU var denne information stadig 10 Petaflops.

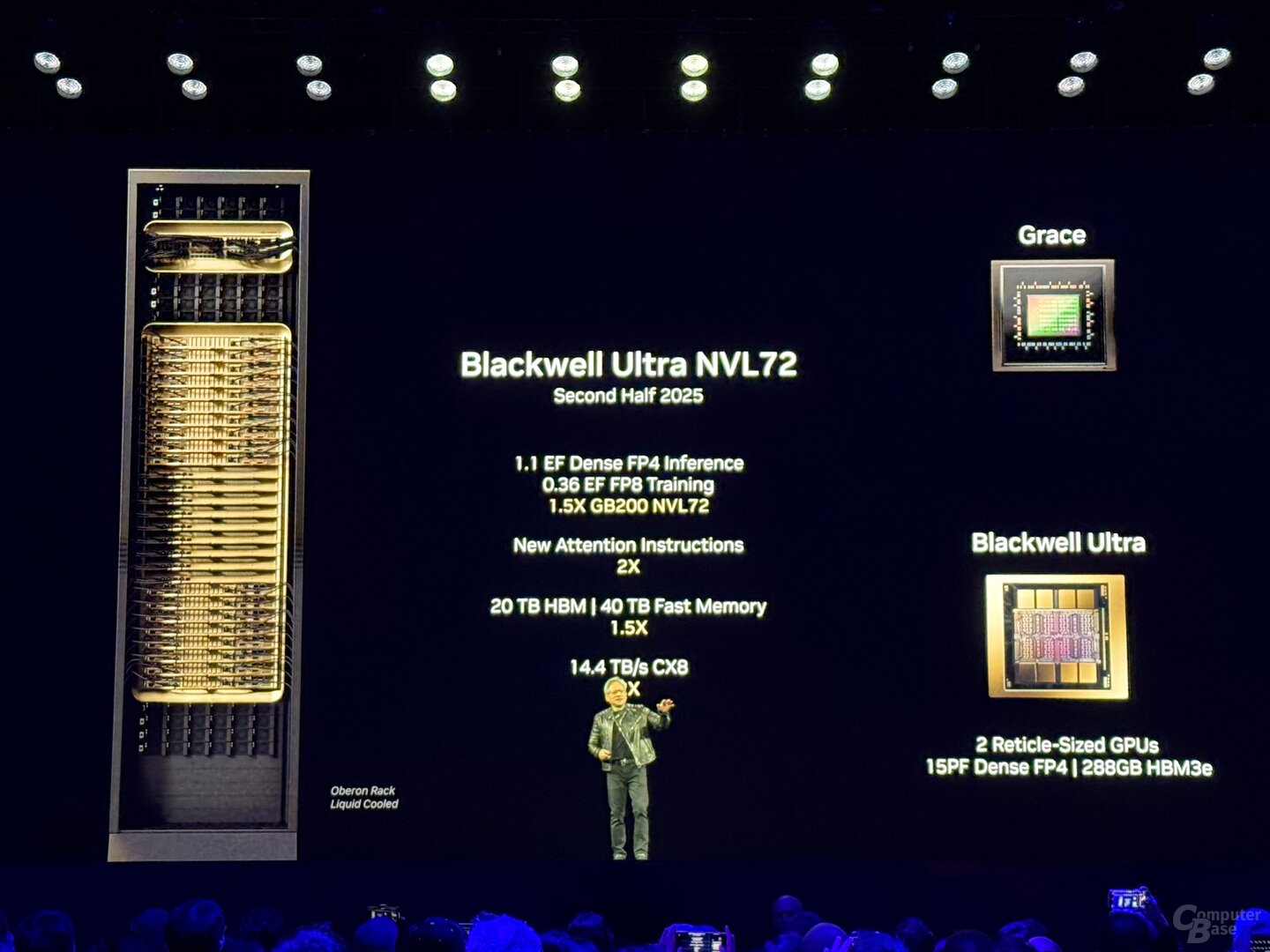

GB300 NVL72 med 72 GPU’er og 1.1 exaflops

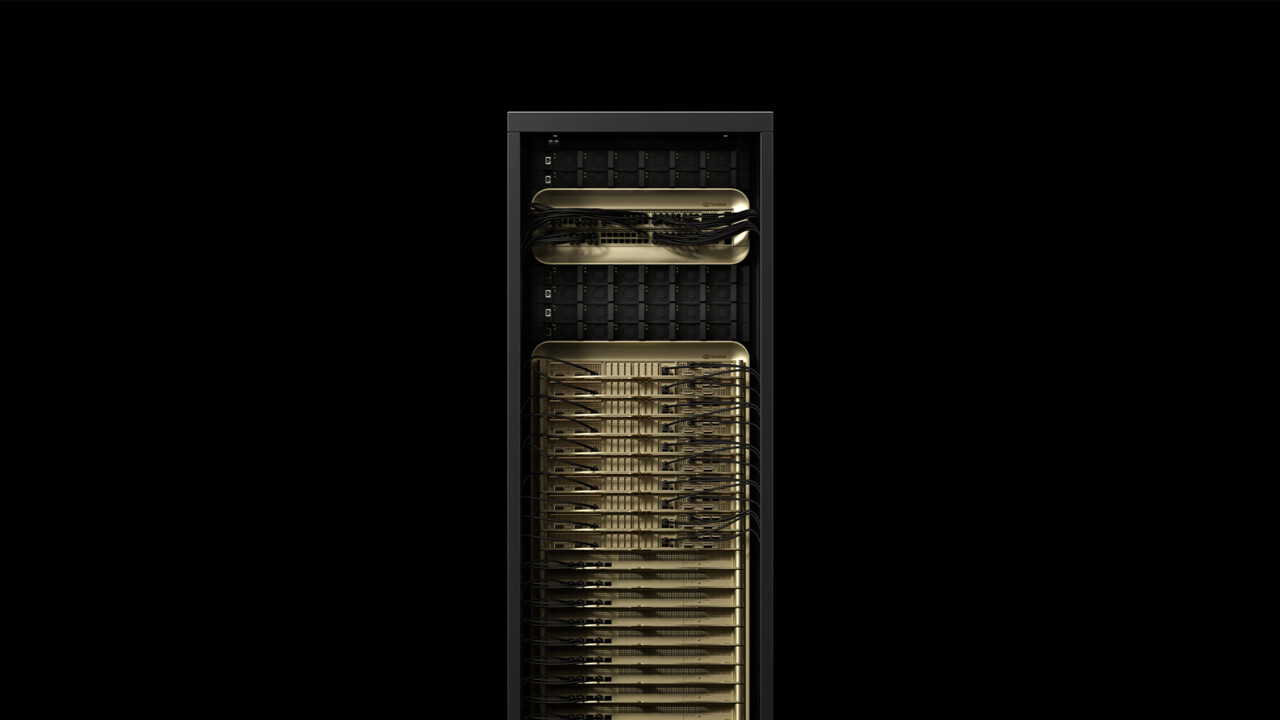

Da den første tilgængelighed begynder i anden halvdel af 2025, skal den yderligere udvikling bruges i to datacenterløsninger fra NVIDIA: GB300 NVL72 og HGX B300 NVL16. GB300 NVL72 er en videreudvikling af det velkendte GB200 NVL72 rack, som kombinerer 72 Blackwell GPU’er med 36 Grace CPU’er med ARM arkitektur i et vandkølet serverskab.

Med GB300 NVL72 er det ikke anderledes, også her danner i alt 36 boards, hver med to GPU’er og en CPU, grundlaget for løsningen. En GB300 NVL72 har i alt 1,1 exaflops, 20 TB (20.736 GB) HBM3E og 40 TB LPDDDR5X til Grace-processorer. Sammenlignet med det tidligere rack burde der heller ikke være nogen mere detaljerede effektivitetsforbedringer væk fra computerkortene.

GB300 NVL72

GB300 NVL72

NvLink med 1,8 TB/s udgør rygraden

Rygraden, der forbinder de enkelte chips til “én stor GPU” udgør 5. generation af NVLink med en båndbredde på 1,8 TB/s pr. GPU og i alt 130 TB/s. NVLink blev også brugt som en multi-node interconnect fra Blackwell, som tidligere blev behandlet via Infiniband med 100 GB/s, så Nvidia taler om en 18x ydelsesforøgelse for dette specifikke scenarie. Den tilhørende “NvLink Switch 7.2T” sidder også i stativet og er en ikke mindre imponerende chip. NVIDIA har også NVLink-switchen fremstillet i 4NP hos TSMC og beløber sig til 50 milliarder transistorer – det er næsten to tredjedele af Hopper H100-transistorerne. Op til 576 GPU’er kan tilføjes til et NVLink-domæne.

HGX B300 med x86-processor

Med HGX B300 NVL16 tilbyder NVIDIA også en løsning uden sin egen ARM CPU. Ligesom frafaldet af “G”-signaler i navnet, har Grace CPU’en ikke denne løsning, i stedet bruges 16 B300 B300- og x86-processorer af NVLink. På processorsiden er AMD og Intel tidligere kommet med på vognen.

Serverleverandører og CSP’er er ombord

Ifølge Nvidia ønsker Cisco, Dell, Hewlett Packard Enterprise, Lenovo og Supermicro at tilbyde en bred vifte af Blackwell-Ultra-produkter, senere Aivre, Asrock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron og Wiwynn. Blandt de cloud-tjenesteudbydere, der ønsker at tilbyde Blackwell Ultra, AWS, Google Cloud, Microsoft Azure og Oracle. Blackwell-gpus i skyen ønsker også at tilbyde Coreweave, Crusoe, Lambda, Nebius, Nscale, Yotta og Ytl.

Techtip modtog information om denne vare fra NVIDIA under NDA på forhånd og som en del af en producentbegivenhed i San Jose, Californien. Udgifterne til ankomst, afgang og fem hotelovernatninger blev afholdt af selskabet. Der var ingen indflydelse fra producenten og heller ikke pligt til at indberette. Det eneste krav i NDA var det tidligst mulige udgivelsestidspunkt.

Emner: Grafikkort kunstig intelligens Nvidia Nvidia Blackwell Nvidia GTC 2025 Kilde: Nvidia

Alexandre, uddannet ingeniør, deler sin viden om GPU-ydeevne til gaming og kreativt arbejde.