GB300 NVL72: Nvidia Blackwell Ultra se actualiza a 288 GB HBM3E 17 comentarios

Imagen: nvidia

Nvidia presentó un mayor desarrollo de la arquitectura Blackwell actual con Blackwell Ultra para GTC 2025. Esto debería hacer que la solución del centro de datos se ajuste a la edad para los modelos de implementación de IA con un mayor requisito de inferencia.

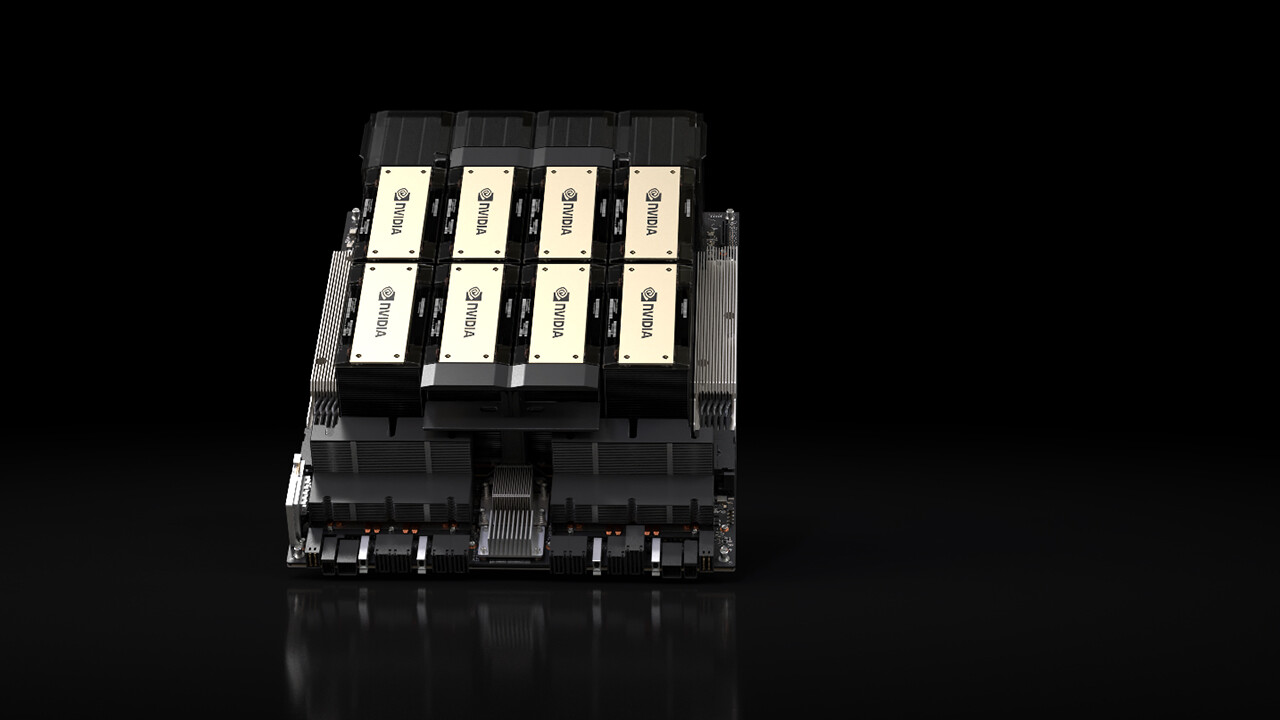

La GPU B300 es una evolución de la GPU B200 presentada el año pasado, con la que NVIDIA anunció la arquitectura Blackwell y que ha estado en el centro de datos de varios proveedores de servicios en la nube (CSP) desde finales del año pasado. Blackwell Ultra se basa en la misma arquitectura y, por lo tanto, también incluye dos de ellas, que están conectadas entre sí a través de una matriz.

Centrarse en inferir modelos de transferencia de IA

Blackwell Ultra se desarrolló, entre otras cosas, para las mayores exigencias a la hora de inferir modelos de transferencia de IA, que deben procesar y gastar rápidamente varios cientos de miles de tokens por solicitud, porque también presentan la solicitud al usuario bajo demanda y, por lo tanto, requieren un mayor esfuerzo computacional.

HBM3E alcanza los 288 GB

Para cumplir con estos requisitos, Nvidia amplía principalmente la memoria del Blackwell Ultra hasta 288 GB HBM3E, basándose en los 192 GB HBM3E cerca del Blackwell con GPU B200. La memoria de ancho de banda un 50% mayor vuelve a distribuir Nvidia en ocho pilas alrededor de la GPU, pero las pilas respectivas ahora son 12 en lugar de 8 chips DRAM, de modo que se logra una densidad de almacenamiento un 50% mayor en la misma área.

Rendimiento de inferencia 1,5x FP4

Según NVIDIA, Blackwell Ultra ofrecería 1,5 veces el rendimiento de inferencia FP4 en comparación con Blackwell, la compañía habla de 15 petaflops para FP4 denso, es decir, sin la aceleración escasa, con la que son posibles 30 flops PETA. Para la GPU Blackwell original, esta información seguía siendo de 10 petaflops.

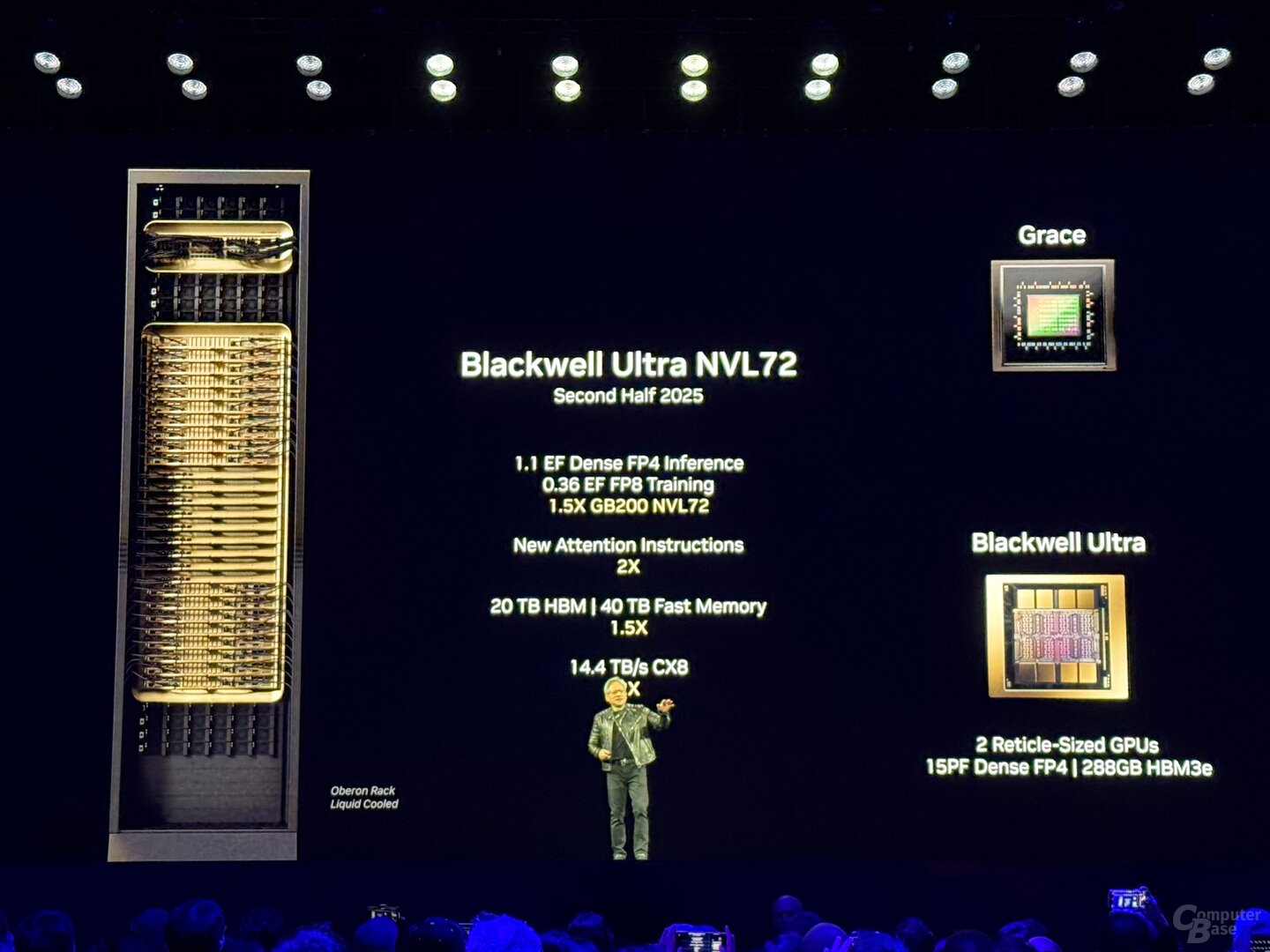

GB300 NVL72 con 72 GPU y 1,1 exaflops

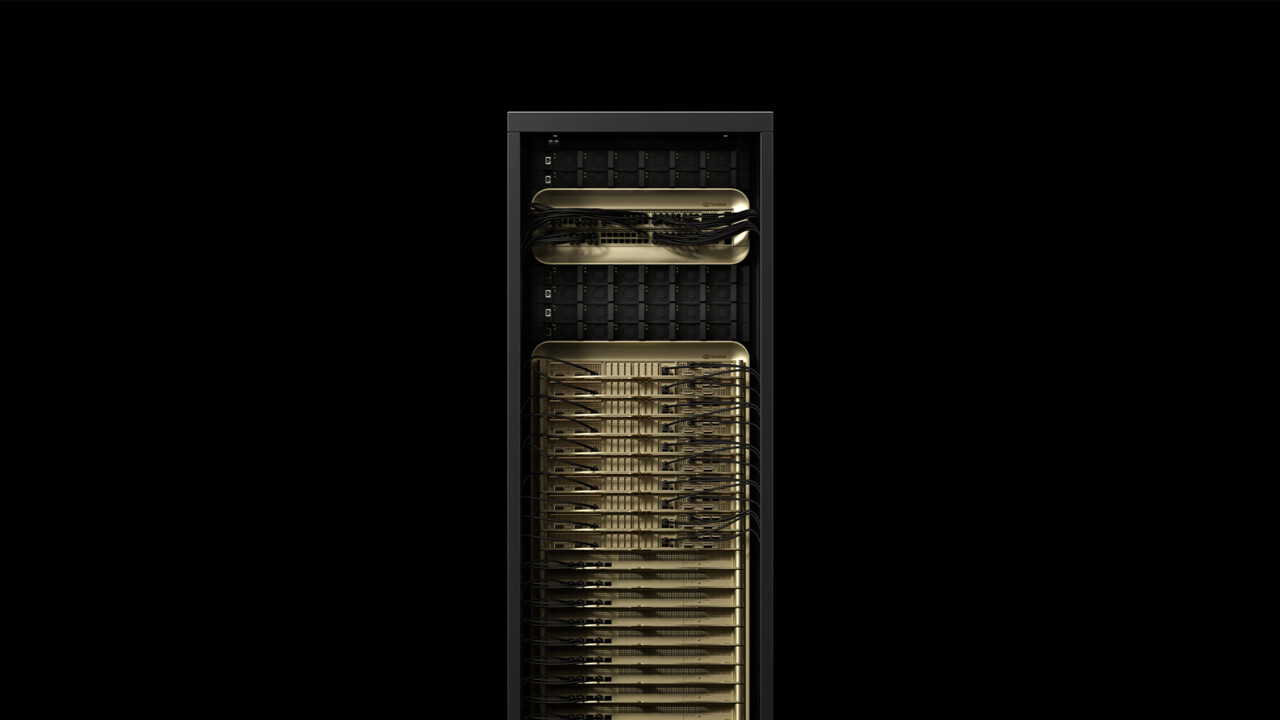

Dado que la disponibilidad inicial comienza en la segunda mitad de 2025, el desarrollo adicional se utilizará en dos soluciones de centro de datos de NVIDIA: GB300 NVL72 y HGX B300 NVL16. GB300 NVL72 es una evolución del conocido rack GB200 NVL72, que combina 72 GPU Blackwell con 36 CPU Grace con arquitectura ARM en un gabinete de servidor refrigerado por agua.

Con GB300 NVL72 no es diferente, aquí también un total de 36 placas, cada una con dos GPU y una CPU, forman la base de la solución. Un GB300 NVL72 tiene un total de 1,1 exaflops, 20 TB (20.736 GB) HBM3E y 40 TB LPDDDR5X para los procesadores Grace. En comparación con el rack anterior, tampoco debería haber mejoras de eficiencia más detalladas fuera de las tarjetas de cómputo.

GB300 NVL72

GB300 NVL72

NvLink con 1,8 TB/s forma la columna vertebral

La columna vertebral que conecta los chips individuales a “una gran GPU” forma la quinta generación del NVLink con un ancho de banda de 1,8 TB/s por GPU y un total de 130 TB/s. NVLink también se utilizó como interconexión multinodo de Blackwell, que anteriormente se procesaba a través de Infiniband con 100 GB/s, por lo que Nvidia habla de un aumento de rendimiento de 18 veces para este escenario específico. El “NvLink Switch 7.2T” asociado también se encuentra en el rack y es un chip no menos impresionante. NVIDIA también tiene el conmutador NVLink fabricado en 4NP en TSMC y asciende a 50 mil millones de transistores: son casi dos tercios de los transistores Hopper H100. Se pueden agregar hasta 576 GPU a un dominio NVLink.

HGX B300 con procesador x86

Con HGX B300 NVL16, NVIDIA también ofrece una solución sin CPU ARM propia. Al igual que la renuncia a las señales “G” en el nombre, la CPU Grace no tiene esta solución, en su lugar NVLink utiliza 16 procesadores B300 B300 y x86. En el lado de los procesadores, AMD e Intel se han subido al carro en el pasado.

Los proveedores de servidores y los CSP están a bordo

Según Nvidia, Cisco, Dell, Hewlett Packard Enterprise, Lenovo y Supermicro quieren ofrecer una amplia gama de productos Blackwell-Ultra, más tarde Aivre, Asrock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron y Wiwynn. Entre los proveedores de servicios en la nube que quieren ofrecer Blackwell Ultra se encuentran AWS, Google Cloud, Microsoft Azure y Oracle. Blackwell-gpus en la nube también quiere ofrecer Coreweave, Crusoe, Lambda, Nebius, Nscale, Yotta e Ytl.

Techtip recibió información sobre este artículo de NVIDIA bajo NDA por adelantado y como parte de un evento de fabricantes en San José, California. Los gastos de llegada, salida y cinco alojamientos en hotel corrieron a cargo de la empresa. No hubo influencia del fabricante ni obligación de informar. El único requisito de la NDA era la fecha de publicación más temprana posible.

Temas: Tarjetas gráficas Inteligencia artificial Nvidia Nvidia Blackwell Nvidia GTC 2025 Fuente: Nvidia

Ingeniero de formación, Alexandre comparte sus conocimientos sobre el rendimiento de las GPUs para gaming y creación.