GB300 NVL72: Nvidia Blackwell Ultra passe à 288 Go HBM3E 17 commentaires

Image: nvidia

Nvidia a présenté un développement ultérieur de l'architecture Blackwell actuelle avec Blackwell Ultra pour le GTC 2025. Cela devrait rendre la solution de centre de données ajustée pour l'âge des modèles de mise en œuvre de l'IA avec une exigence d'inférence plus élevée.

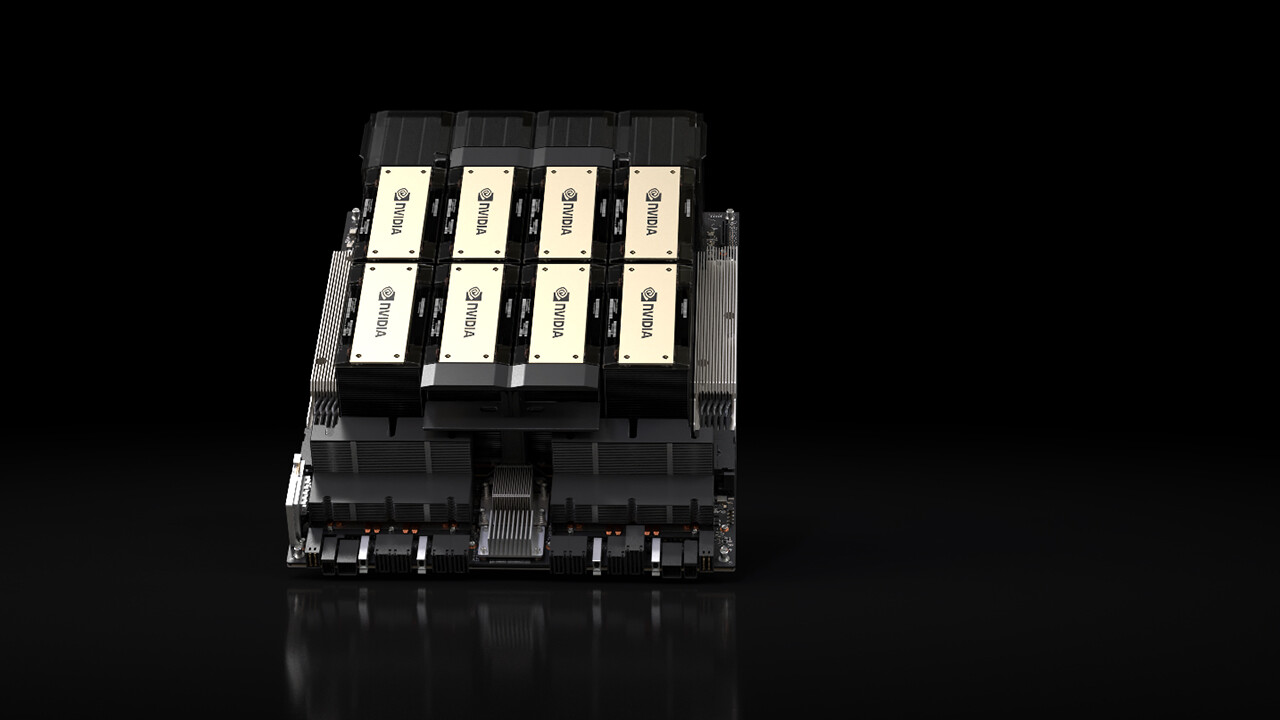

Le B300 GPU est un développement supplémentaire du GPU B200 présenté l'année dernière, avec lequel NVIDIA a annoncé l'architecture Blackwell et qui a été avec plusieurs fournisseurs de services cloud (CSP) dans le centre de données depuis la fin de l'année dernière. Blackwell Ultra s'appuie sur la même architecture et comprend donc également deux de ceci, qui sont connectés les uns aux autres via une matrice.

Concentrez-vous sur l'inférence des modèles de transfert d'IA

Blackwell Ultra a été développé, entre autres, pour les exigences plus élevées lors de l'inférence des modèles de transfert de l'IA, qui doivent traiter et dépenser rapidement plusieurs centaines de milliers de jetons par demande, car ils présentent également la demande à la demande à l'utilisateur et exigent ainsi un effort informatique plus élevé.

HBM3E atteint 288 Go

Afin de répondre à ces exigences, Nvidia étend principalement la mémoire de Blackwell Ultra jusqu'à 288 Go HBM3E, sur la base de 192 Go HBM3E près de Blackwell avec le GPU B200. La mémoire de bande passante à 50% plus grande distribue à nouveau Nvidia sur huit piles autour du GPU, mais les piles respectives sont maintenant 12 au lieu de 8 puces DRAM, de sorte qu'une densité de stockage de 50% plus élevée est obtenue sur la même zone.

1,5 fois les performances d'inférence FP4

Selon le NVIDIA, Blackwell Ultra offrirait 1,5 fois les performances d'inférence FP4 par rapport à Blackwell, la société parle de 15 Petaflops pour les denses FP4, c'est-à-dire sans l'accélération de la rareté, avec laquelle 30 flops PETA sont possibles. Pour le GPU Blackwell original, ces informations étaient encore 10 Petaflops.

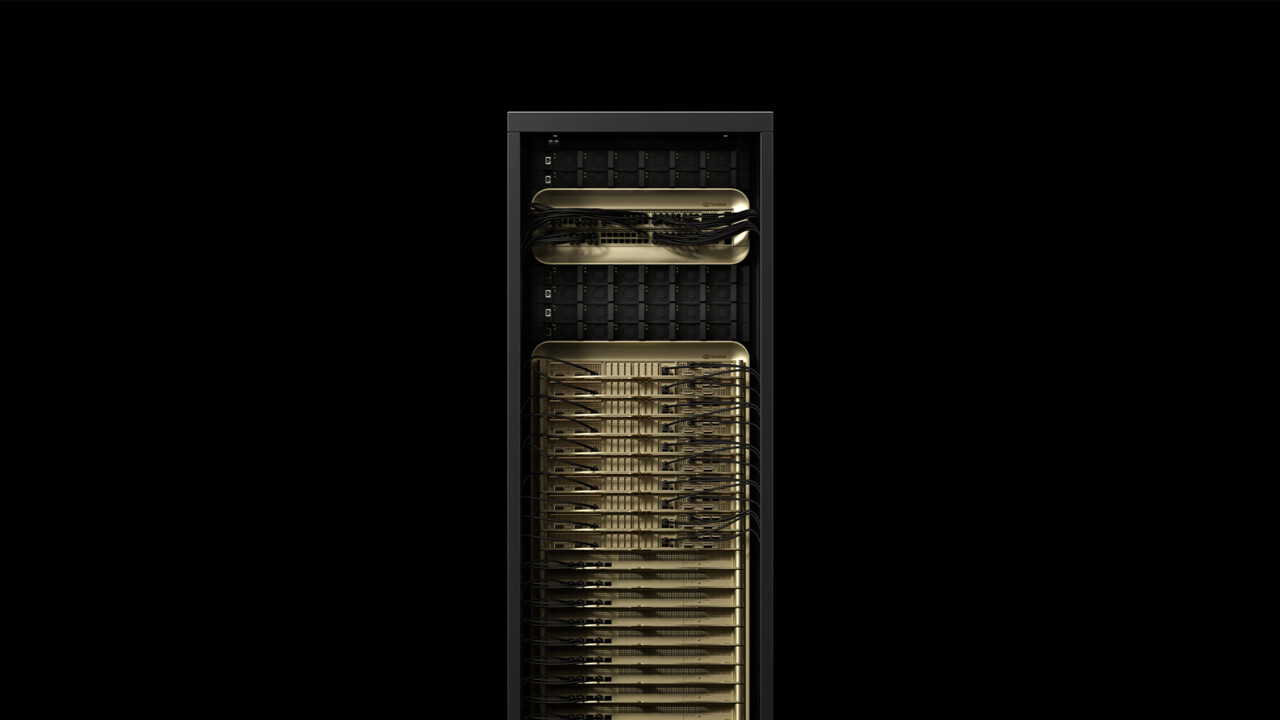

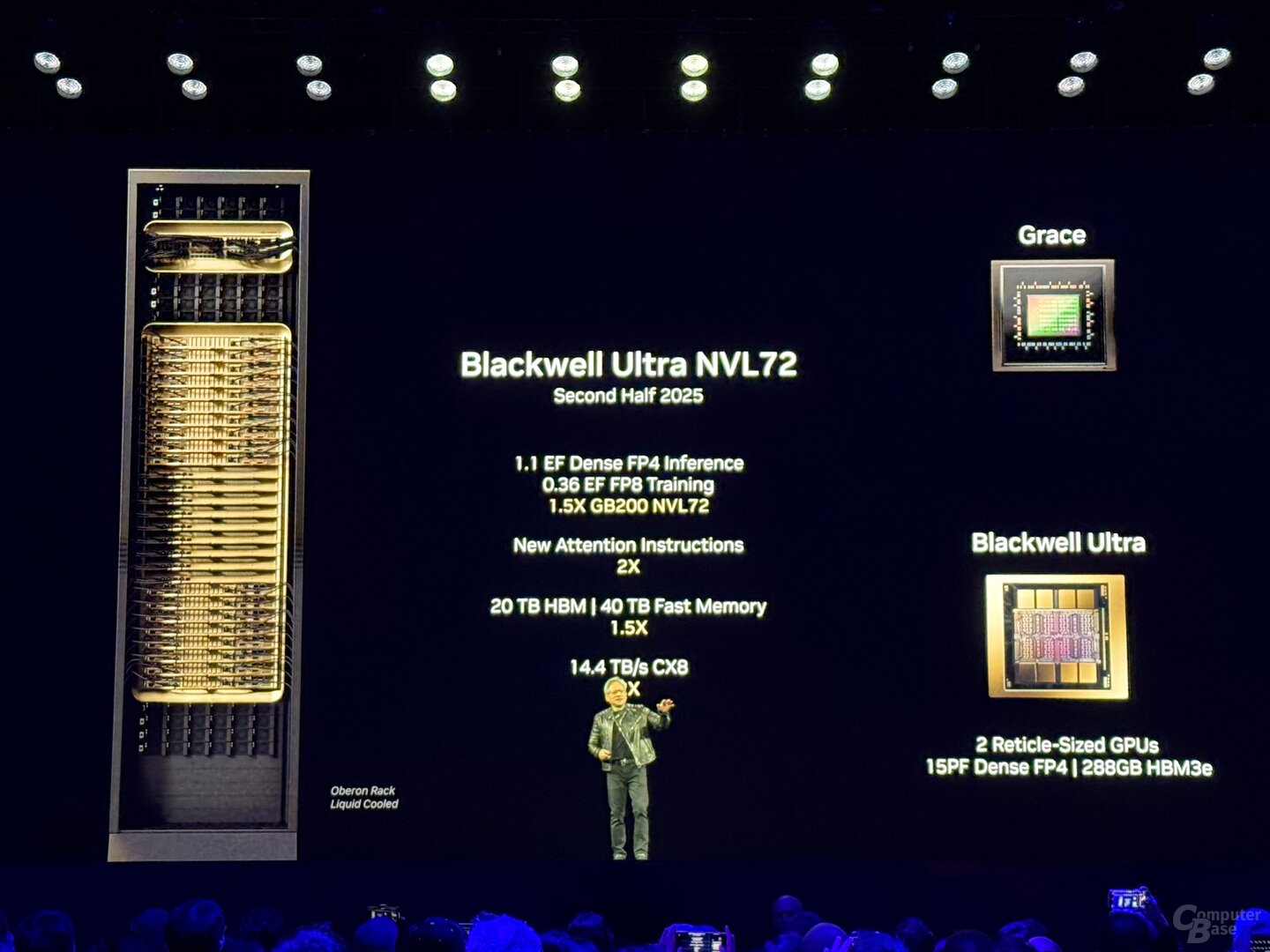

GB300 NVL72 avec 72 GPU et 1,1 exaflops

Au début de la disponibilité initiale au second semestre de 2025, le développement supplémentaire doit être utilisé dans deux solutions de centre de données de NVIDIA: GB300 NVL72 et HGX B300 NVL16. GB300 NVL72 est un développement supplémentaire du rack bien connu de GB200 NVL72, qui combine 72 GPU Blackwell avec 36 CPU Grace avec architecture ARM dans une armoire de serveur refroidie par eau.

Avec GB300 NVL72, ce n'est pas différent, ici aussi, un total de 36 planches, chacune avec deux GPU et un CPU, forment la base de la solution. Un GB300 NVL72 a un total de 1,1 exaflops, 20 To (20 736 Go) HBM3E et 40 TB LPDDDR5X pour les processeurs Grace. Par rapport au rack précédent, il ne devrait pas non plus y avoir d'améliorations d'efficacité plus détaillées loin des cartes de calcul.

GB300 NVL72

GB300 NVL72

NvLink avec 1,8 To / s forme l'épine dorsale

L'épine dorsale qui relie les puces individuelles à « un grand GPU » forme la 5e génération du NVLink avec une bande passante de 1,8 To / s par GPU et un total de 130 To / s. NVLink a également été utilisé comme interconnexion multi-nœuds depuis Blackwell, qui a été précédemment traité via Infiniband avec 100 Go / s, donc Nvidia parle d'une augmentation des performances de 18x pour ce scénario spécifique. Le « NvLink Switch 7.2T » associé se trouve également dans le rack et est une puce non moins impressionnante. NVIDIA a également l'interrupteur NVLink fabriqué dans 4NP à TSMC et s'élève à 50 milliards de transistors – ce sont près des deux tiers des transistors Hopper H100. Jusqu'à 576 GPU peuvent être ajoutés à un domaine NVLink.

HGX B300 avec processeur x86

Avec HGX B300 NVL16, NVIDIA propose également une solution sans son propre CPU ARM. Comme la renonciation des signaux « G » dans le nom, le CPU Grace n'a pas cette solution, à la place, 16 processeurs B300 B300 et x86 sont utilisés par NVLink. De la part du processeur, AMD et Intel sont venus dans le train dans le passé.

Les fournisseurs de serveurs et les CSP sont à bord

Selon Nvidia, Cisco, Dell, Hewlett Packard Enterprise, Lenovo et Supermicro veulent offrir une large gamme de produits Blackwell-Ultra, plus tard Aivre, Asrock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron et Wiwynn. Parmi les fournisseurs de services cloud qui souhaitent offrir à Blackwell Ultra, AWS, Google Cloud, Microsoft Azure et Oracle. Blackwell-gpus dans le nuage veut également offrir à Coreweave, Crusoe, Lambda, Nebius, Nscale, Yotta et Ytl.

Techastuce a reçu des informations sur cet article de NVIDIA sous NDA à l'avance et dans le cadre d'un événement du fabricant à San Jose, en Californie. Le coût d'arrivée, le départ et cinq logements hôteliers ont été supportés par l'entreprise. Il n'y avait aucune influence du fabricant ni une obligation de signaler. La seule exigence de la NDA a été la première fois de publication possible.

Sujets: Cartes graphiques Intelligence artificielle Nvidia Nvidia Blackwell Nvidia GTC 2025 Source: Nvidia

Ingénieur de formation, Alexandre partage ses connaissances sur les performances des GPU pour le gaming et la création.