GB300 NVL72: Nvidia Blackwell Ultra si aggiorna a 288 GB HBM3E 17 commenti

Immagine: nvidia

Nvidia ha presentato un ulteriore sviluppo dell’attuale architettura Blackwell con Blackwell Ultra per GTC 2025. Ciò dovrebbe rendere la soluzione del data center adeguata all’età per i modelli di implementazione dell’intelligenza artificiale con un requisito di inferenza più elevato.

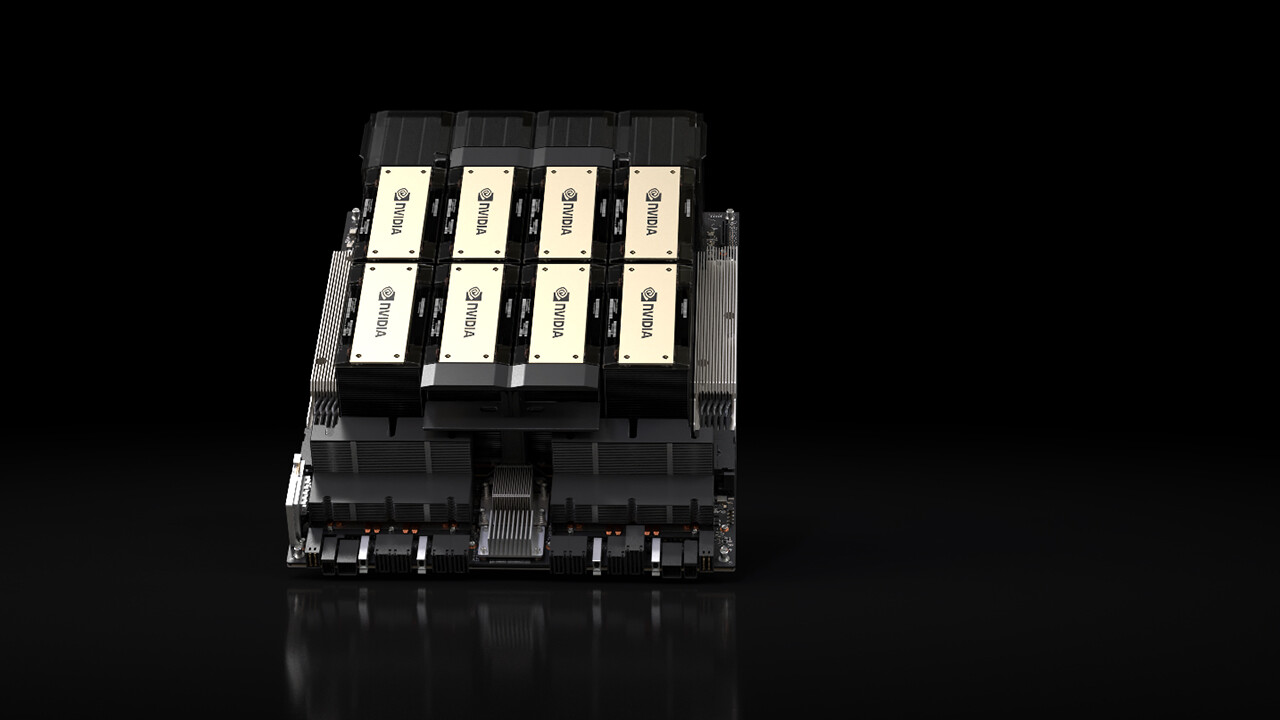

La GPU B300 è un ulteriore sviluppo della GPU B200 presentata l’anno scorso, con la quale NVIDIA ha annunciato l’architettura Blackwell e che dalla fine dello scorso anno è presente presso diversi fornitori di servizi cloud (CSP) nel data center. Blackwell Ultra si basa sulla stessa architettura e quindi ne comprende anche due, collegati tra loro tramite una matrice.

Concentrarsi sulla deduzione di modelli di trasferimento AI

Blackwell Ultra è stato sviluppato tra l’altro per le esigenze più elevate nella deduzione di modelli di trasferimento AI, che devono elaborare rapidamente e spendere diverse centinaia di migliaia di token per richiesta, perché presentano la richiesta anche su richiesta all’utente e richiedono quindi un maggiore sforzo di calcolo.

HBM3E raggiunge i 288 GB

Per soddisfare questi requisiti, Nvidia espande principalmente la memoria del Blackwell Ultra fino a 288 GB HBM3E, sulla base dell’HBM3E da 192 GB vicino Blackwell con GPU B200. La memoria con larghezza di banda maggiore del 50% distribuisce nuovamente Nvidia su otto stack attorno alla GPU, ma i rispettivi stack sono ora 12 invece di 8 chip DRAM, in modo da ottenere una densità di archiviazione superiore del 50% sulla stessa area.

Prestazioni di inferenza FP4 1,5x

Secondo NVIDIA, Blackwell Ultra offrirebbe 1,5 volte le prestazioni di inferenza FP4 rispetto a Blackwell, l’azienda parla di 15 Petaflop per FP4 denso, cioè senza l’accelerazione di scarsità, con la quale sono possibili 30 flop PETA. Per la GPU Blackwell originale, questa informazione era ancora di 10 Petaflop.

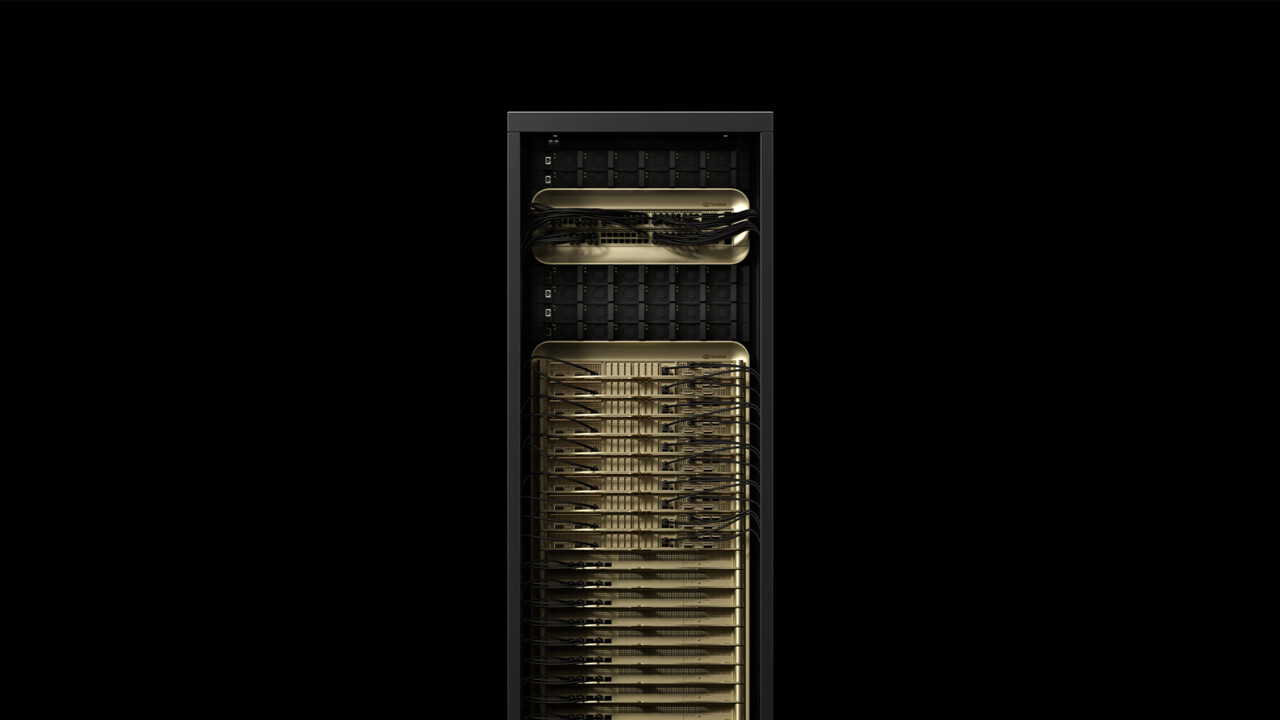

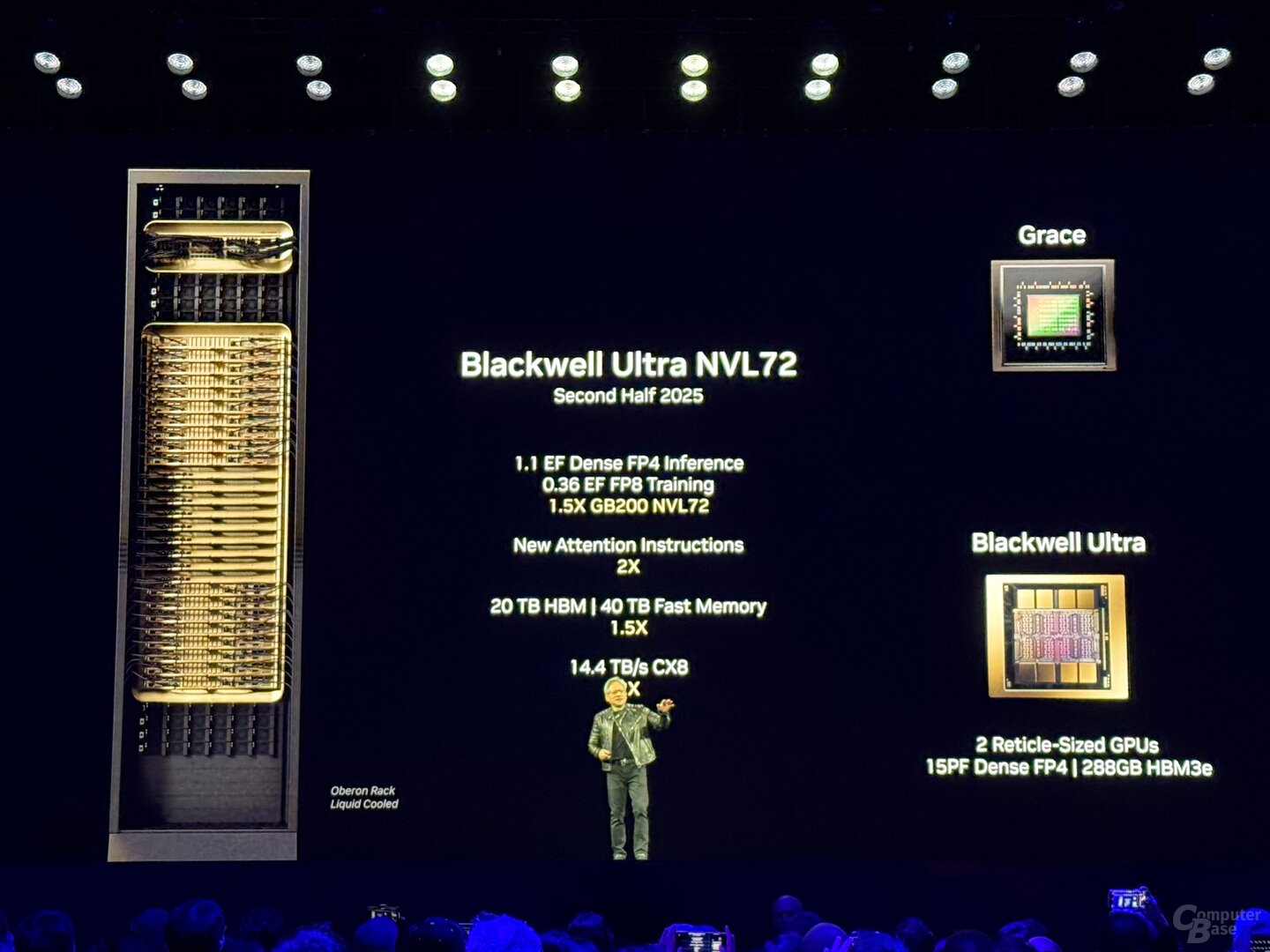

GB300 NVL72 con 72 GPU e 1,1 exaflop

Poiché la disponibilità iniziale inizierà nella seconda metà del 2025, lo sviluppo aggiuntivo sarà utilizzato in due soluzioni per data center di NVIDIA: GB300 NVL72 e HGX B300 NVL16. GB300 NVL72 è un ulteriore sviluppo del noto rack GB200 NVL72, che combina 72 GPU Blackwell con 36 CPU Grace con architettura ARM in un armadio server raffreddato ad acqua.

Con GB300 NVL72 non è diverso, anche qui un totale di 36 schede, ciascuna con due GPU e una CPU, costituiscono la base della soluzione. Un GB300 NVL72 ha un totale di 1,1 exaflop, 20 TB (20.736 GB) HBM3E e 40 TB LPDDDR5X per processori Grace. Rispetto al rack precedente, non dovrebbero esserci miglioramenti di efficienza più dettagliati nemmeno lontano dalle schede di calcolo.

GB300NVL72

GB300NVL72

NvLink con 1,8 TB/s costituisce la spina dorsale

La dorsale che collega i singoli chip ad “una grande GPU” costituisce la quinta generazione di NVLink con una larghezza di banda di 1,8 TB/s per GPU e un totale di 130 TB/s. NVLink è stato utilizzato anche come interconnessione multi-nodo di Blackwell, che in precedenza veniva elaborato tramite Infiniband con 100 GB/s, quindi Nvidia parla di un aumento delle prestazioni di 18 volte per questo scenario specifico. Anche il relativo “NvLink Switch 7.2T” si trova nel rack ed è un chip non meno impressionante. NVIDIA ha anche lo switch NVLink prodotto in 4NP presso TSMC e ammonta a 50 miliardi di transistor: si tratta di quasi due terzi dei transistor Hopper H100. È possibile aggiungere fino a 576 GPU a un dominio NVLink.

HGX B300 con processore x86

Con HGX B300 NVL16, NVIDIA offre anche una soluzione senza la propria CPU ARM. Come la rinuncia ai segnali “G” nel nome, la CPU Grace non ha questa soluzione, invece NVLink utilizza 16 processori B300 B300 e x86. Dal punto di vista dei processori, AMD e Intel sono salite sul carro in passato.

I fornitori di server e i CSP sono a bordo

Secondo Nvidia, Cisco, Dell, Hewlett Packard Enterprise, Lenovo e Supermicro vogliono offrire un’ampia gamma di prodotti Blackwell-Ultra, poi Aivre, Asrock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron e Wiwynn. Tra i fornitori di servizi cloud che vogliono offrire Blackwell Ultra, AWS, Google Cloud, Microsoft Azure e Oracle. Blackwell-gpus nel cloud vuole offrire anche Coreweave, Crusoe, Lambda, Nebius, Nscale, Yotta e Ytl.

Techtip ha ricevuto informazioni su questo articolo da NVIDIA in anticipo sotto NDA e come parte di un evento del produttore a San Jose, in California. Le spese di arrivo, partenza e cinque sistemazioni alberghiere sono state a carico dell’azienda. Non vi è stata alcuna influenza da parte del produttore né obbligo di segnalazione. L’unico requisito della NDA era la prima data di pubblicazione possibile.

Argomenti: Schede grafiche Intelligenza artificiale Nvidia Nvidia Blackwell Nvidia GTC 2025 Fonte: Nvidia

Ingegnere di formazione, Alexandre condivide le sue conoscenze sulle prestazioni delle GPU per gaming e creazione.