Nvidia Kyber: Un Superpod DGX comprime solo un rack di 6 commenti

Con il superpod Blackwell Ultra DGX, Nvidia ha presentato un “supercomputer AI pronto all’uso”, il supercomputer Blackwell Ultra DGX, che fornisce potenza di calcolo per progetti AI con 576 GPU su 11 EXAFLOPS (FP4). Tuttavia, ciò che è ancora distribuito su quattro rack potrebbe presto adattarsi a uno solo, come dimostra il rack Kyber di Nvidia.

Scalabilità spinta verso l’alto

Il ridimensionamento doveva essere fatto prima del ridimensionamento, ha spiegato ieri al pubblico il CEO di Nvidia Jensen Huang. Ciò che sentiamo è una compressione dei componenti prima della sua larghezza. Nvidia sta guidando questo prossimo progetto con rack regolarmente compattati e raggiungendo il picco preliminare con il rack Kyber al GTC 2025.

Il rack Kyber è stato solo indirettamente un problema per il discorso, bisognava prestare molta attenzione alle note a piè di pagina per trovare il nome di sviluppo del rack “Kyber” oltre all’immagine del Rubin Ultra NVL576 previsto per la seconda metà del 2027. Invece, lo sguardo è caduto rapidamente sui numeri giganteschi attorno al Rubin Ultra con un’enorme GPU a 4 traslochi.

Kyber fa tutto diversamente

Già la vista frontale di Kyber mostrata nel keynote suggeriva che Nvidia non solo avesse confezionato i componenti qui, ma avrebbe anche avuto un aspetto completamente diverso nel rack. Analogamente alla tabella di marcia dichiarata fino al 2028, Nvidia si è rivelata sorprendentemente aperta alle prossime generazioni di server alla propria fiera GTC e aveva già esposto Kyber e i nuovi componenti necessari per questa attività solo come prova di concetto. Ma tenendo conto del fatto che Jensen Huang ha mostrato il Rubin Ultra NVL576 in questo telaio in copertina, si può presumere.

Kyber Rack Immagine 1 di 8

576 GPU in un singolo rack

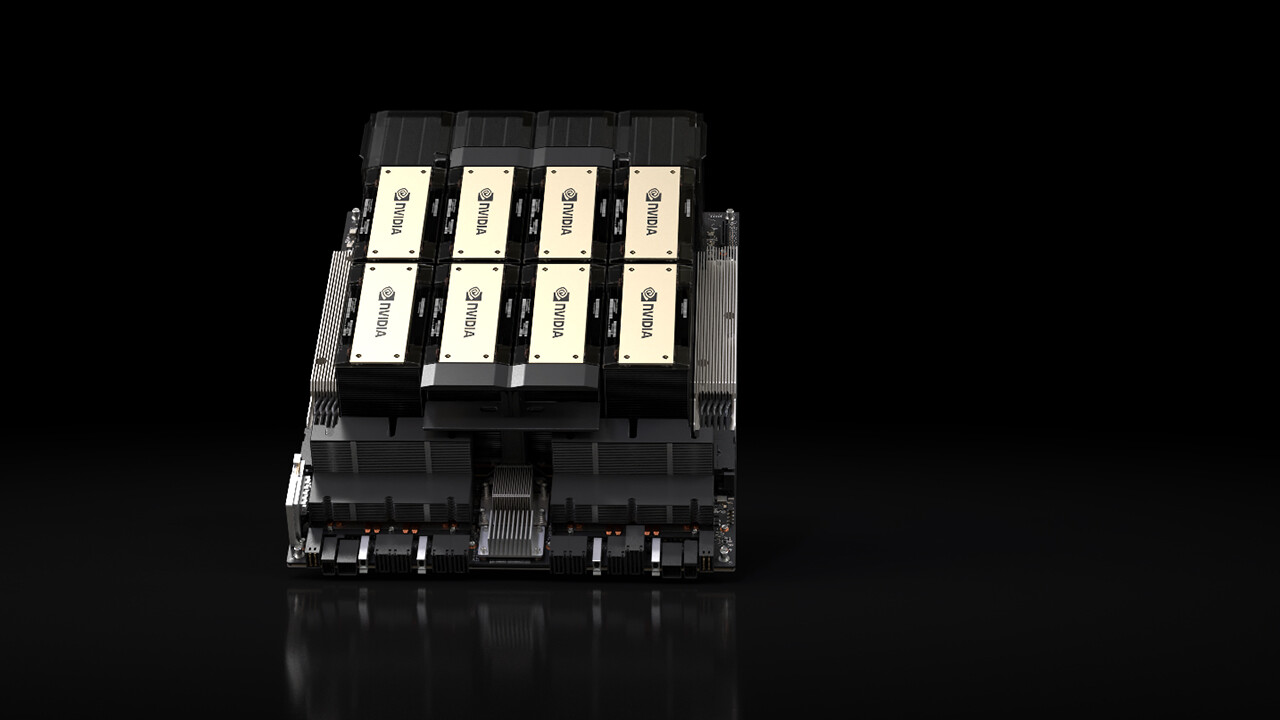

Rubin Ultra NVL576, tra gli altri, porta 144 pacchetti di chip abbinati a un totale di 576 GPU attraverso più switch NVLink in un singolo rack. Secondo Huang, il rack ha un fabbisogno energetico di 600 kW. Per fare un confronto: con GB200 NVL72 (e GB300 NVL144), 132 kW e per rack 144 GPU (nuovo metodo di conteggio per GB300) sono divise in 72 chip packages, 36 GRACE CPUS e nove switch NVLink.

Kyber può fare a meno di un cavo in rame nvlink

Nvidia punta quindi ad un rack GPU Compression Pro di un fattore 4x con Rubin Ultra rispetto a Rubin, Blackwell Ultra e Blackwell. Per fare ciò è necessario rinnovare completamente la struttura della scaffalatura, come dimostra in modo impressionante Kyber. Con GB300 NVL144 e Vera Rubin NVL144, NVIDIA installa i 18 vassoi di calcolo con 8 GPU e 2 CPU in ciascuno dei cassetti del rack, i nove switch NVLink si trovano uno sopra l’altro tra i primi dieci e i restanti otto vassoi di calcolo. La “spina dorsale” del sistema è costituita da 3,2 chilometri di cavi in rame sul retro del rack, che collegano i vassoi di elaborazione con gli switch NVLink per creare “una grande GPU”.

GB300 NVL72 da dietro con cavi in rame per switch NVLink Immagine 1 di 3

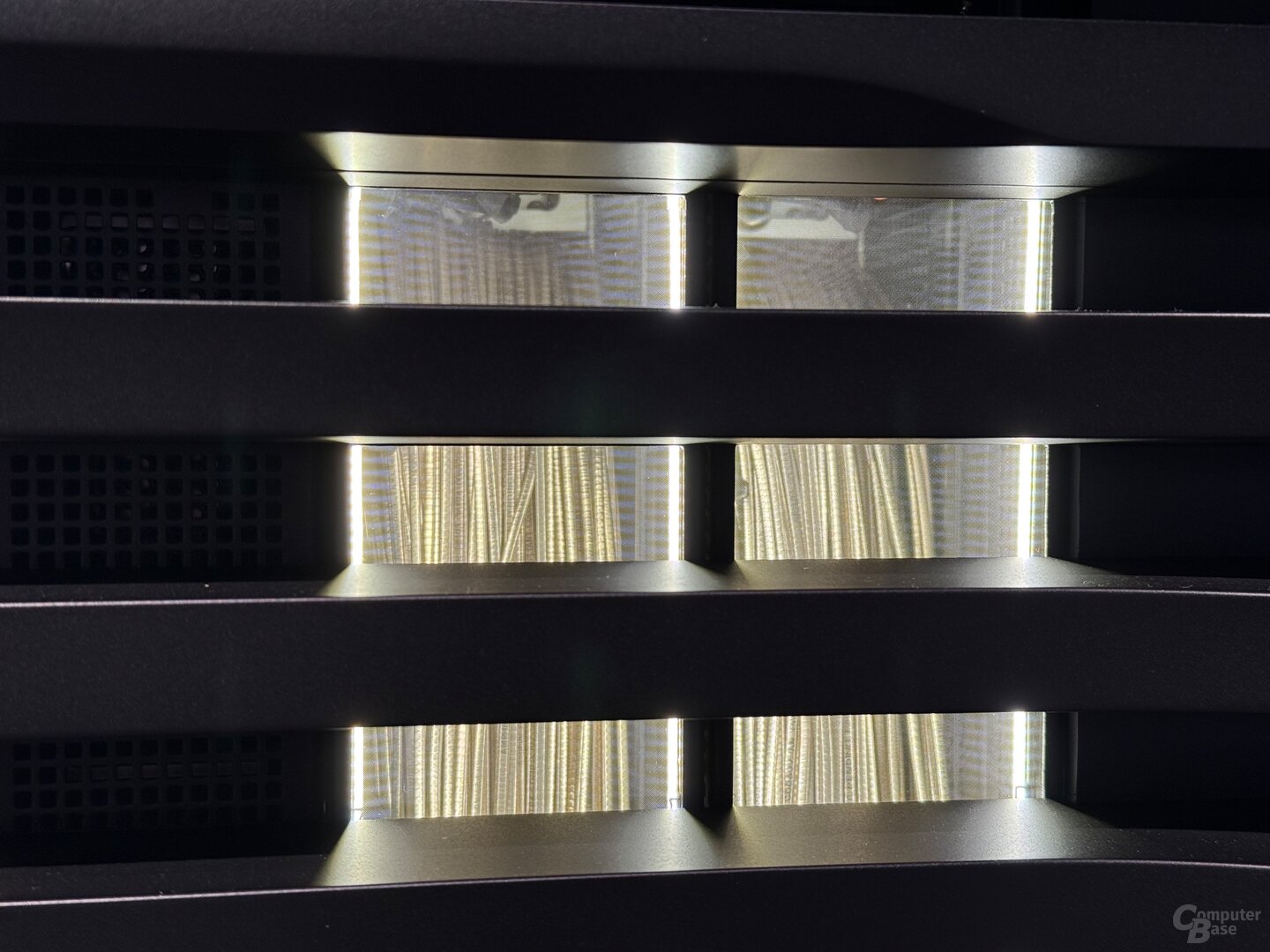

Kyber non solo costruisce poeti, ma fa anche a meno di questi cavi. Invece dei piatti, Nvidia si affida ai blade per gli switch di calcolo e nvlink, che vengono ruotati di 90 gradi come libri su uno scaffale. Kyber può assorbire quattro blocchi di 18 blade di elaborazione per un totale di 72 blade di elaborazione. In Kyber, ogni blade di elaborazione ha solo circa la metà della profondità di costruzione rispetto ai piatti Blackwell, poiché NVIDIA passa da una struttura liquida ibrida a un’esclusiva struttura raffreddata a fluido che non richiede più un dissipatore di calore e una ventola convenzionali. Questa volta, il raffreddamento fluido include davvero tutti i componenti, ovvero non solo GPU e CPU, ma anche storage, DPU, rete e altro ancora, quindi i fan non devono più far saltare le schede.

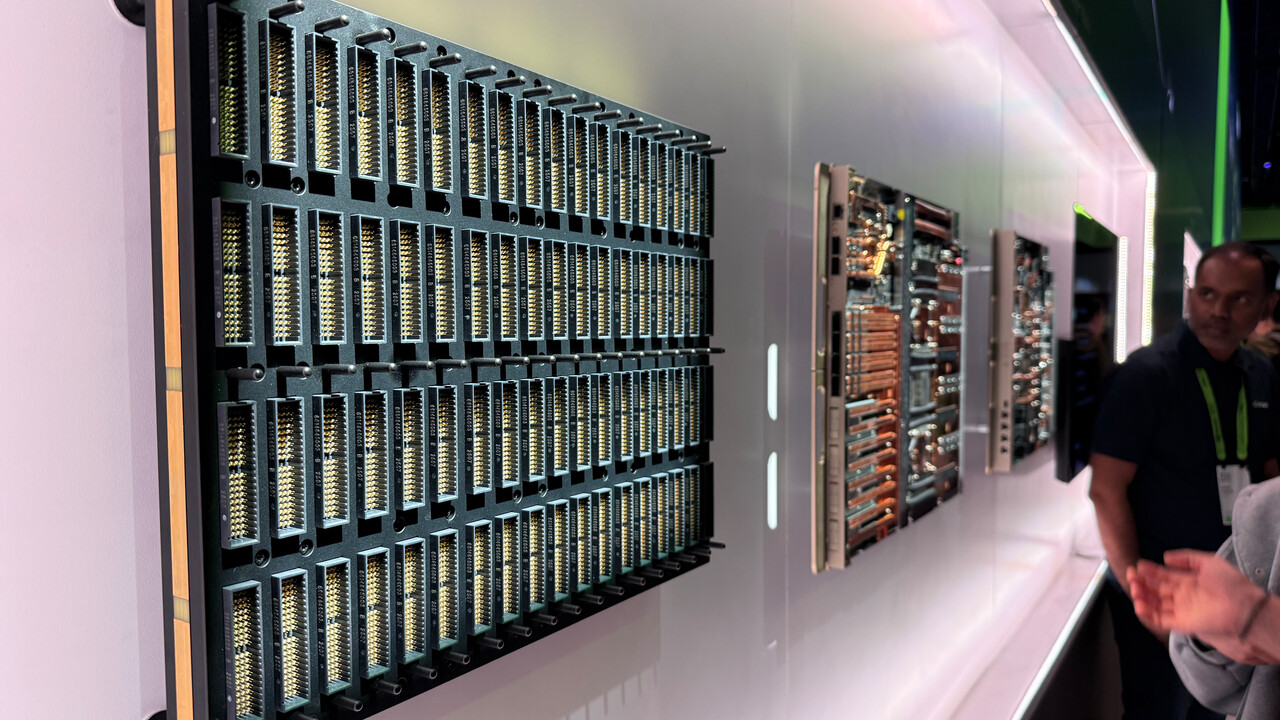

PCB midplane come nuova parte midplane

Ma dove sono richiesti gli switch NVLink in Kyber? Questi includono la seconda metà della profondità di costruzione dei rack conformi agli standard in termini di dimensioni direttamente dietro i blade di elaborazione. Tra i due si trova perpendicolare alle lame, che sono realizzate dalla parte anteriore e posteriore, un nuovo PCB midfield con punti di contatto su entrambi i lati per registrare le lame di calcolo dalla parte anteriore e dietro le lame di commutazione NVLink con le corrispondenti parti di connessione. In quest’area del rack funziona anche il raffreddamento a liquido, ciascuno con entrambe le connessioni di ciascun computer e switch nvlink. Nel risultato finale, per quanto riguarda il numero di GPU, viene creato un rack con 144 chip package per un totale di 576 GPU, perché Rubin Ultra quattro invece di due GPU formano un chip package.

Elementi costitutivi di Kyber Rack Immagine 1 di 3

Superpod Blackwell Ultra DGX

Quest’anno, tuttavia, i clienti Nvidia devono ancora “essere contenti” del superpod Blackwell Ultra DGX annunciato al GTC, che offre anch’esso 576 GPU, ma le distribuisce comunque su quattro rack con raffreddamento ibrido. Il nuovo superpod è commercializzato da Nvidia come un “supercomputer AI in the box”, che con 576 Blackwell-Ultra-GPUS e 288 CPU Grace raggiunge una potenza di calcolo di 11,5 exaflop per FP4. Il superpod Blackwell Ultra DGX dovrebbe essere offerto dai partner Nvidia entro la fine dell’anno.

Nvidia Blackwell Ultra Dgx Superpod (Immagine: Nvidia)

Nvidia Blackwell Ultra Dgx Superpod (Immagine: Nvidia)

Techtip ha ricevuto informazioni su questo articolo da Nvidia come parte di un evento del produttore a San Jose, California. Le spese di arrivo, partenza e cinque sistemazioni alberghiere sono state a carico dell’azienda. Non vi è stata alcuna influenza da parte del produttore né obbligo di segnalazione.

Argomenti: schede grafiche intelligenza artificiale nvidia nvidia gtc 2025

Ingegnere di formazione, Alexandre condivide le sue conoscenze sulle prestazioni delle GPU per gaming e creazione.