GB300 NVL72: Nvidia Blackwell Ultra atualiza para 288 GB HBM3E 17 comentários

Imagem: nvidia

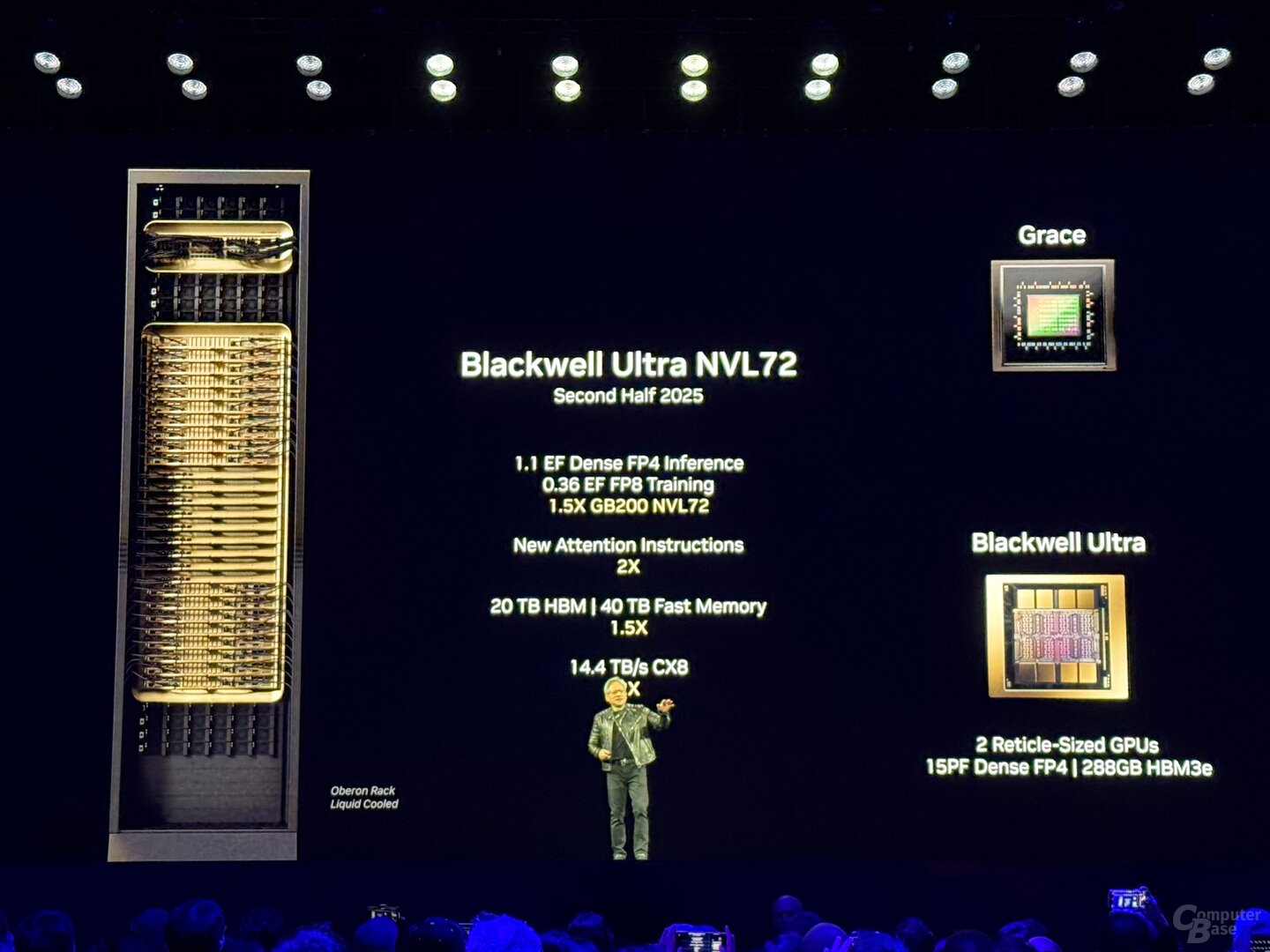

A Nvidia apresentou um desenvolvimento adicional da arquitetura Blackwell atual com Blackwell Ultra para GTC 2025. Isso deve tornar a solução de data center ajustada à idade para modelos de implementação de IA com um requisito de inferência mais alto.

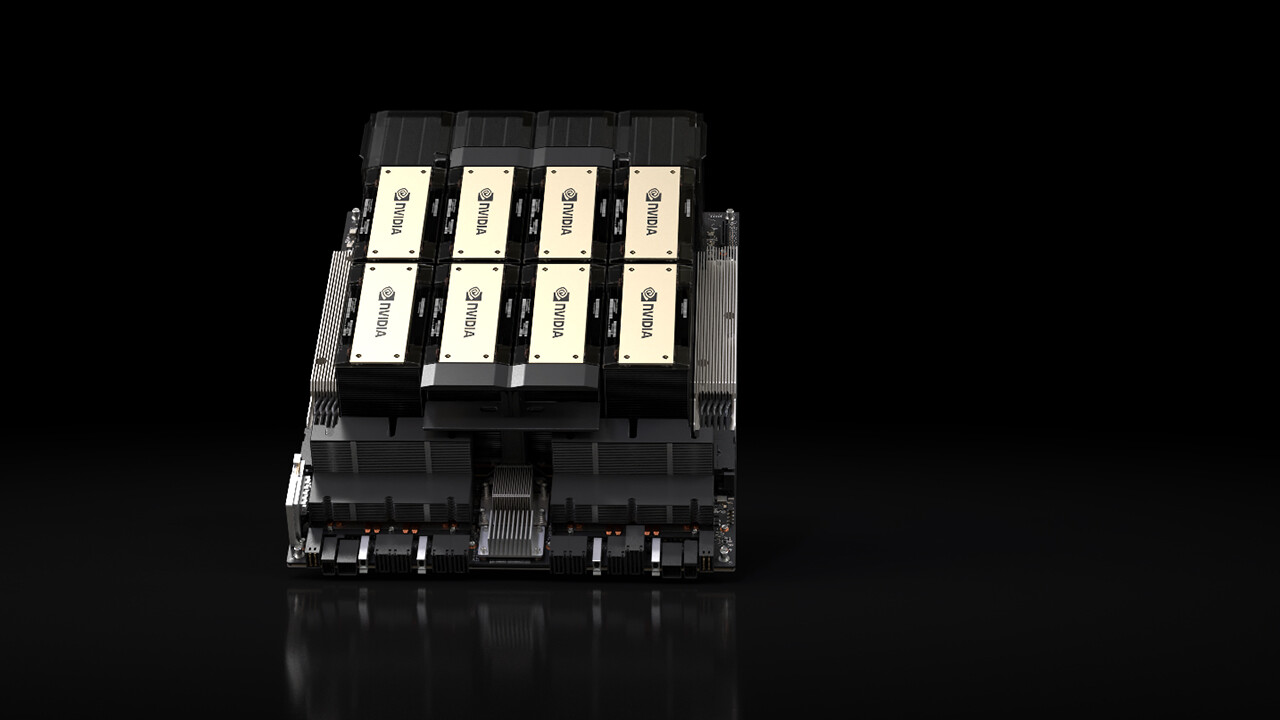

A GPU B300 é um desenvolvimento adicional da GPU B200 apresentada no ano passado, com a qual a NVIDIA anunciou a arquitetura Blackwell e que está com vários provedores de serviços em nuvem (CSPs) no data center desde o final do ano passado. Blackwell Ultra depende da mesma arquitetura e, portanto, também inclui duas delas, que são conectadas entre si por meio de uma matriz.

Concentre-se em inferir modelos de transferência de IA

O Blackwell Ultra foi desenvolvido, entre outras coisas, para as maiores demandas ao inferir modelos de transferência de IA, que devem processar rapidamente e gastar várias centenas de milhares de tokens por solicitação, porque também apresentam a solicitação sob demanda ao usuário e, portanto, exigem maior esforço computacional.

HBM3E atinge 288 GB

Para atender a esses requisitos, a Nvidia expande principalmente a memória do Blackwell Ultra até 288 GB HBM3E, com base no HBM3E de 192 GB próximo ao Blackwell com GPU B200. A memória com largura de banda 50% maior distribui novamente a Nvidia em oito pilhas ao redor da GPU, mas as respectivas pilhas agora são 12 em vez de 8 chips DRAM, de modo que uma densidade de armazenamento 50% maior é alcançada na mesma área.

Desempenho de inferência FP4 1,5x

Segundo a NVIDIA, o Blackwell Ultra ofereceria 1,5 vezes o desempenho de inferência do FP4 comparado ao Blackwell, a empresa fala em 15 Petaflops para FP4 denso, ou seja, sem a aceleração de esparsidade, com a qual são possíveis 30 flops PETA. Para a GPU Blackwell original, essa informação ainda era de 10 Petaflops.

GB300 NVL72 com 72 GPUs e 1.1 exaflops

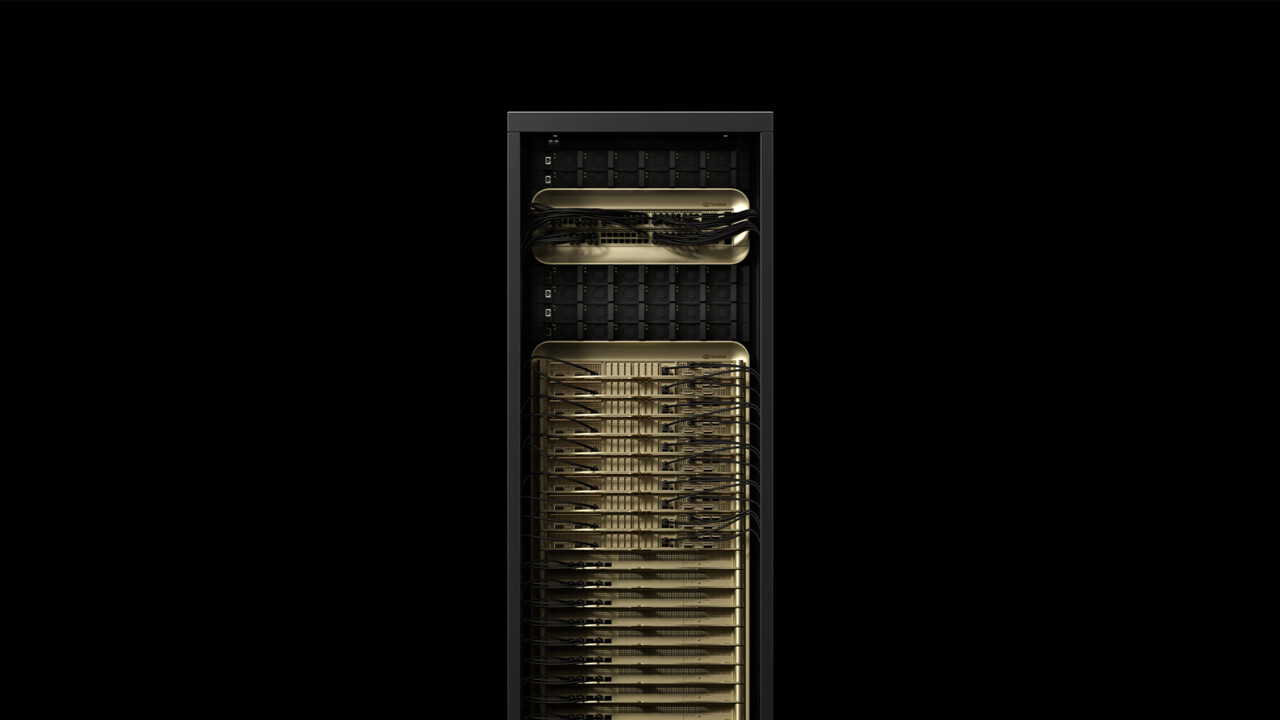

Como a disponibilidade inicial começa no segundo semestre de 2025, o desenvolvimento adicional será usado em duas soluções de data center da NVIDIA: GB300 NVL72 e HGX B300 NVL16. GB300 NVL72 é um desenvolvimento adicional do conhecido rack GB200 NVL72, que combina 72 GPUs Blackwell com 36 CPUs Grace com arquitetura ARM em um gabinete de servidor refrigerado a água.

Com o GB300 NVL72 não é diferente, aqui também um total de 36 placas, cada uma com duas GPUs e uma CPU, formam a base da solução. Um GB300 NVL72 tem um total de 1,1 exaflops, 20 TB (20.736 GB) HBM3E e 40 TB LPDDDR5X para processadores Grace. Comparado ao rack anterior, também não deve haver melhorias de eficiência mais detalhadas nas placas de computação.

GB300 NVL72

GB300 NVL72

NvLink com 1,8 TB/s forma a espinha dorsal

O backbone que conecta os chips individuais a “uma grande GPU” forma a 5ª geração do NVLink com uma largura de banda de 1,8 TB/s por GPU e um total de 130 TB/s. O NVLink também foi usado como uma interconexão multi-node da Blackwell, que anteriormente era processada via Infiniband com 100 GB/s, então a Nvidia está falando sobre um aumento de desempenho de 18x para este cenário específico. O “NvLink Switch 7.2T” associado também fica no rack e não é um chip menos impressionante. A NVIDIA também possui o switch NVLink fabricado em 4NP na TSMC e equivale a 50 bilhões de transistores – estes são quase dois terços dos transistores Hopper H100. Até 576 GPUs podem ser adicionadas a um domínio NVLink.

HGX B300 com processador x86

Com o HGX B300 NVL16, a NVIDIA também oferece uma solução sem CPU ARM própria. Assim como a dispensa dos sinais “G” no nome, a CPU Grace não possui esta solução, em vez disso, 16 processadores B300 B300 e x86 são usados pelo NVLink. No lado do processador, a AMD e a Intel aderiram ao movimento no passado.

Fornecedores de servidores e CSPs estão a bordo

De acordo com Nvidia, Cisco, Dell, Hewlett Packard Enterprise, Lenovo e Supermicro querem oferecer uma ampla gama de produtos Blackwell-Ultra, mais tarde Aivre, Asrock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron e Wiwynn. Entre os provedores de serviços em nuvem que desejam oferecer estão Blackwell Ultra, AWS, Google Cloud, Microsoft Azure e Oracle. Blackwell-gpus na nuvem também quer oferecer Coreweave, Crusoe, Lambda, Nebius, Nscale, Yotta e Ytl.

A Techtip recebeu informações sobre este item da NVIDIA sob NDA antecipadamente e como parte de um evento do fabricante em San Jose, Califórnia. Os custos de chegada, saída e cinco hospedagens em hotel foram arcados pela empresa. Não houve influência do fabricante nem obrigação de reportar. O único requisito do NDA era o prazo de publicação mais cedo possível.

Tópicos: Placas Gráficas Inteligência Artificial Nvidia Nvidia Blackwell Nvidia GTC 2025 Fonte: Nvidia

Engenheiro de formação, Alexandre compartilha seu conhecimento sobre o desempenho de GPUs para jogos e criação.