GB300 NVL72: Nvidia Blackwell Ultra uppgraderar till 288 GB HBM3E 17 kommentarer

Bild: nvidia

Nvidia presenterade en vidareutveckling av den nuvarande Blackwell-arkitekturen med Blackwell Ultra för GTC 2025. Detta borde göra datacenterlösningen åldersjusterad för AI-implementeringsmodeller med högre slutledningskrav.

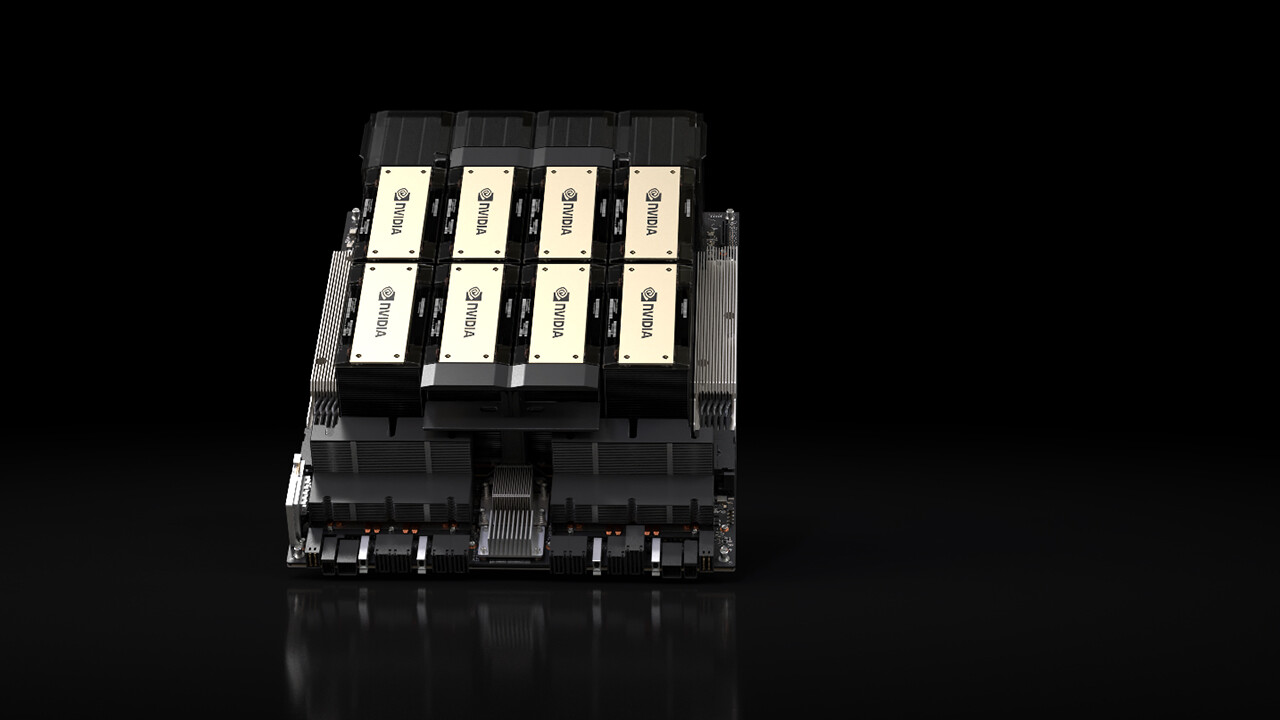

B300 GPU är en vidareutveckling av B200 GPU som presenterades förra året, med vilken NVIDIA tillkännagav Blackwell-arkitekturen och som har funnits hos flera molntjänsteleverantörer (CSP:er) i datacentret sedan slutet av förra året. Blackwell Ultra förlitar sig på samma arkitektur och inkluderar därför även två av dessa, som är kopplade till varandra via en matris.

Fokusera på att härleda AI-överföringsmodeller

Blackwell Ultra utvecklades bland annat för de högre kraven vid slutledning av AI-överföringsmodeller, som snabbt måste bearbeta och spendera flera hundra tusen tokens per förfrågan, eftersom de också presenterar förfrågan on demand för användaren och därmed kräver högre beräkningsansträngning.

HBM3E når 288 GB

För att möta dessa krav utökar Nvidia främst minnet hos Blackwell Ultra upp till 288GB HBM3E, baserat på 192GB HBM3E nära Blackwell med B200 GPU. Det 50 % större bandbreddsminnet distribuerar åter Nvidia över åtta stackar runt GPU:n, men respektive stack är nu 12 istället för 8 DRAM-chips, så att 50 % högre lagringstäthet uppnås över samma yta.

1,5x FP4 slutledningsprestanda

Enligt NVIDIA skulle Blackwell Ultra erbjuda 1,5 gånger FP4-inferensprestandan jämfört med Blackwell, företaget talar om 15 Petaflops för tät FP4, det vill säga utan den sparsamma accelerationen, med vilken 30 PETA-flopar är möjliga. För den ursprungliga Blackwell GPU:n var denna information fortfarande 10 Petaflops.

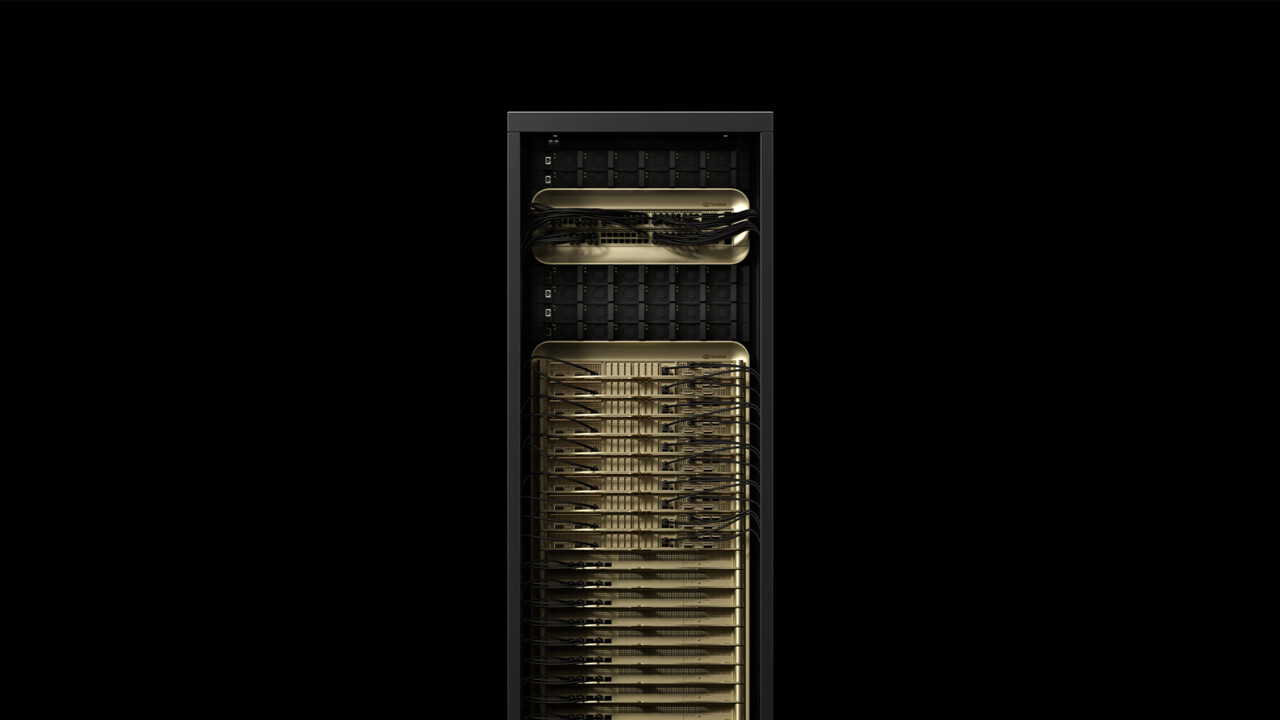

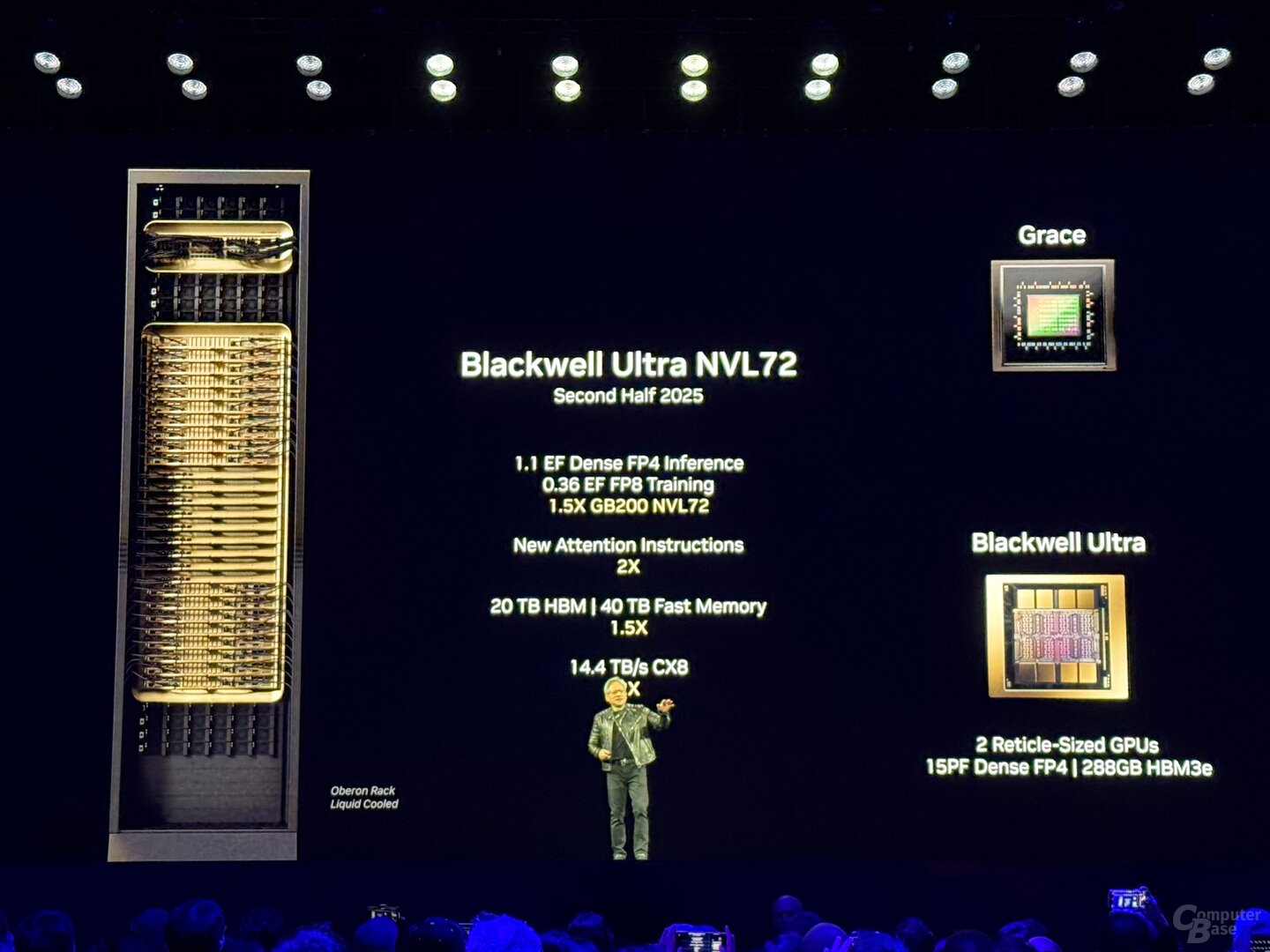

GB300 NVL72 med 72 GPU:er och 1.1 exaflops

Eftersom den initiala tillgängligheten börjar under andra halvan av 2025, ska tilläggsutvecklingen användas i två datacenterlösningar från NVIDIA: GB300 NVL72 och HGX B300 NVL16. GB300 NVL72 är en vidareutveckling av det välkända GB200 NVL72-racket, som kombinerar 72 Blackwell GPU:er med 36 Grace CPU:er med ARM-arkitektur i ett vattenkylt serverskåp.

Med GB300 NVL72 är det inte annorlunda, även här utgör totalt 36 kort, var och en med två GPU:er och en CPU, grunden för lösningen. En GB300 NVL72 har totalt 1,1 exaflops, 20 TB (20 736 GB) HBM3E och 40 TB LPDDDR5X för Grace-processorer. Jämfört med det tidigare racket borde det inte heller finnas några mer detaljerade effektivitetsförbättringar bort från datorkorten.

GB300 NVL72

GB300 NVL72

NvLink med 1,8 TB/s utgör stommen

Stamnätet som kopplar ihop de enskilda chipsen till ”en stor GPU” bildar den 5:e generationen av NVLink med en bandbredd på 1,8 TB/s per GPU och totalt 130 TB/s. NVLink användes också som en multi-nod interconnect från Blackwell, som tidigare bearbetades via Infiniband med 100 GB/s, så Nvidia talar om en 18x prestandaökning för detta specifika scenario. Den tillhörande ”NvLink Switch 7.2T” sitter också i racket och är ett inte mindre imponerande chip. NVIDIA har även NVLink-switchen tillverkad i 4NP hos TSMC och uppgår till 50 miljarder transistorer – det är nästan två tredjedelar av Hopper H100-transistorerna. Upp till 576 GPU:er kan läggas till en NVLink-domän.

HGX B300 med x86-processor

Med HGX B300 NVL16 erbjuder NVIDIA också en lösning utan egen ARM-processor. Precis som avståendet från ”G”-signaler i namnet har Grace CPU inte denna lösning, istället används 16 B300 B300 och x86 processorer av NVLink. På processorsidan har AMD och Intel kommit på tåget tidigare.

Serverleverantörer och CSP:er finns ombord

Enligt Nvidia vill Cisco, Dell, Hewlett Packard Enterprise, Lenovo och Supermicro erbjuda ett brett utbud av Blackwell-Ultra-produkter, senare Aivre, Asrock, Asus, Eviden, Foxconn, Gigabyte, Inventec, Pegatron, Quanta, Wistron och Wiwynn. Bland de molntjänstleverantörer som vill erbjuda Blackwell Ultra, AWS, Google Cloud, Microsoft Azure och Oracle. Blackwell-gpus i molnet vill även erbjuda Coreweave, Crusoe, Lambda, Nebius, Nscale, Yotta och Ytl.

Techtip fick information om denna artikel från NVIDIA under NDA i förväg och som en del av ett tillverkarevenemang i San Jose, Kalifornien. Kostnaden för ankomst, avresa och fem hotellboenden stod för företaget. Det fanns inget inflytande från tillverkaren eller någon anmälningsplikt. NDA:s enda krav var tidigast möjliga publiceringstid.

Ämnen: Grafikkort Artificiell intelligens Nvidia Nvidia Blackwell Nvidia GTC 2025 Källa: Nvidia

Ingenjör i grunden, Alexandre delar sin kunskap om GPU-prestanda för spel och skapande.